ANTIZIPIERTE ZUKUNFT UND DAS DILEMMA DER INTELLIGENZ

„Bereiten wir uns auf einen radikalen Neustart und eine Art biblisches Endzeit-Szenario vor?“

Im Jahr 2017 publizierte ich einige Gedanken über ‚unsere Zukunft‘. Zugegeben, nicht alle Prognosen waren präzise – sie wurden um Jahre verfehlt, verzerrt durch Kriege, oder eine plötzliche Pandemie. Doch als ich letzte Woche auf den Artikel stieß, traf mich eine vertraute Erkenntnis: Der Verlauf der antizipierten technologischen Fortschritte und deren möglichen Zukünfte sind nicht nur beobachtbar, sondern scheinen vorhersehbar, basierend darauf, wie technologische Entwicklung zu geschehen scheint.

Das hat mich heute dazu motiviert, das, was ich als „antizipierte Zukunft“ bezeichne, erneut aufzugreifen und „das Dilemma der Intelligenz“ neu zu erkunden, wobei ich über das Schicksal der Menschheit angesichts eines sich gerade entwickelnden technologischen Tsunamis nachdenke. Die jüngste Pensionierung des „Atlas“ von Boston Dynamics und die Einführung ihres nächsten humanoiden Roboters – eine Fusion aus Robotik und künstlicher Intelligenz – zeigen, dass die Grenzen des Fortschritts endlos vor uns liegen. Früher wurden uns fliegende Autos und dann selbstfahrende Autos versprochen; vielleicht wird uns das Zwischenspiel bald Teslas Bot Optimus als Chauffeur vorstellen, der uns zu den futuristischen Visionen von Marty McFly und Doc Brown führt.

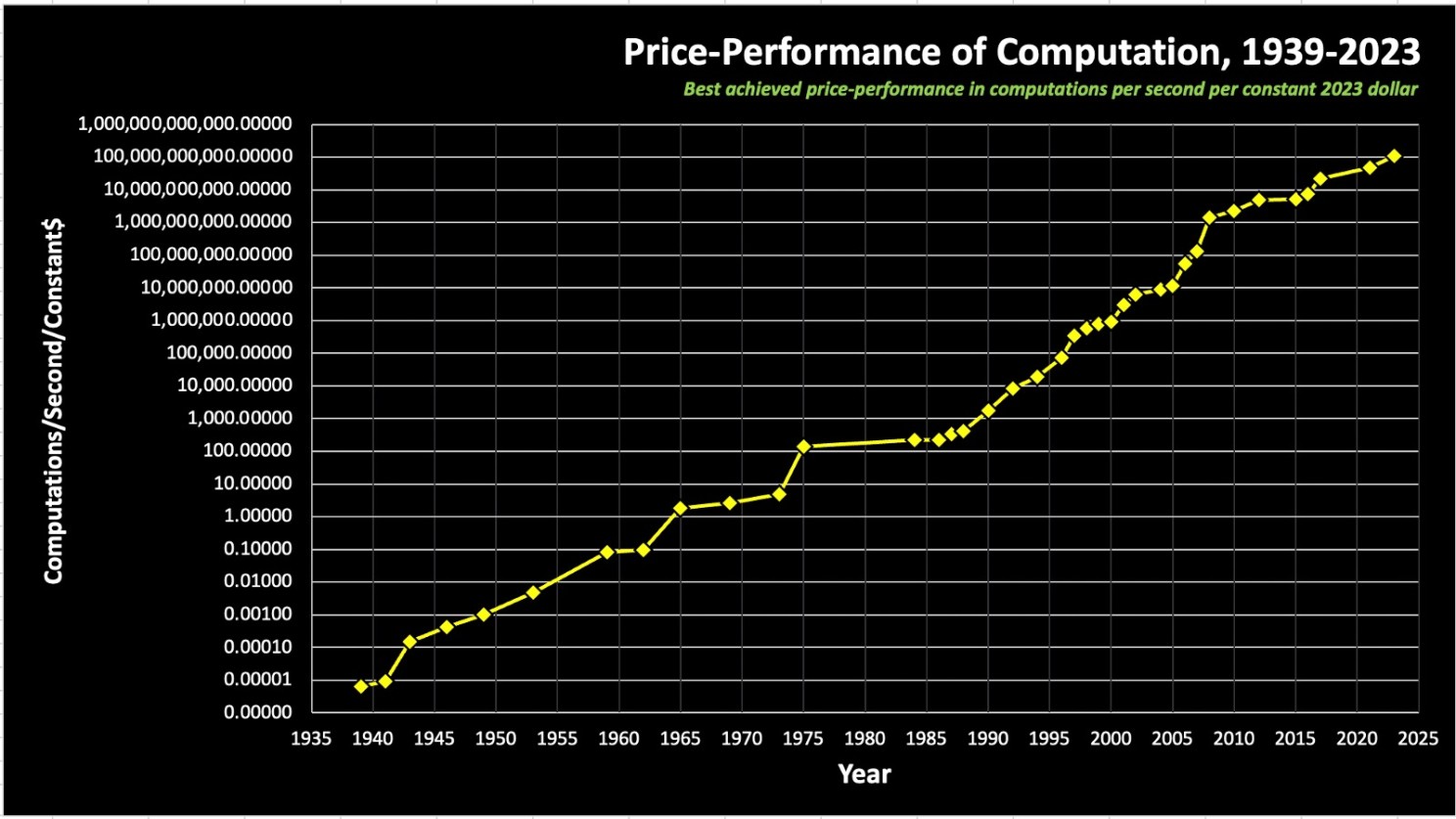

Im Laufe der Jahre wurde die Diskussion über technologische Stagnation lauter. „Moores Gesetz“ – benannt nach Gordon Moore, dem Gründer von Intel im Jahr 1965, der beobachtete, dass sich die Anzahl der Komponenten auf einem Chip etwa alle zwei Jahre verdoppelt – deutete darauf hin, dass die Rechenleistung exponentiell wächst. Kritiker haben den Tod von Moores Gesetz ausgerufen, da sie es für nicht plausibel halten, wenn die technologischen Anforderungen und Kosten der Entwicklung so rasant steigen. Jensen Huang, der CEO von Nvidia, und viele andere haben argumentiert, dass es so ressourcenintensiv geworden ist, dass Moores Gesetz praktisch tot ist. Die jüngsten Fortschritte bei Nvidia fordern diese Vorstellung jedoch heraus, zumindest aus Sicht der Ressourcen hat Nvidia heute die Kapazität, in Fortschritt zu investieren und neue Materialien wie zu verwenden, um die Grenzen weiter zu verschieben.

Seit Jahrzehnten inspiriert mich die Arbeit des Futuristen Ray Kurzweil. Seine Vorhersage von 1999 in „The Age of Spiritual Machines“, dass Computer bis 2029 künstliche Intelligenz auf menschlichem Niveau erreichen und den Turing-Test bestehen könnten, wurde damals mit Skepsis aufgenommen, als Jahrhundertprojekt abgetan, wenn es denn überhaupt realisierbar sei. Doch heute scheint der Horizont für diesen Meilenstein dramatisch näher zu sein – sogar zum Teil innerhalb des nächsten Jahres – während wir uns damit beschäftigen, große Sprachmodelle zu verfeinern, um deren halluzinatorische Tendenzen zu managen und ihre Intelligenz absichtlich zu zügeln, um nicht zu gut zu sein.

Was bedeutet das ‚Dilemma der Intelligenz‘ in diesem Kontext?

Das Problem bei der Verwendung des Begriffs „Intelligenz“ in „Künstliche Intelligenz“ liegt in seinen tiefgreifenden und vielschichtigen Implikationen. Wir könnten auch den künstlichen Aspekt hinterfragen, aber wenn wir Intelligenz menschenähnliche Eigenschaften zuschreiben, beziehen wir uns nicht nur auf die Fähigkeit zu lernen, zu verstehen und Wissen anzuwenden. Wir verstehen damit auch unter anderem emotionale, soziale und kreative Kapazitäten. Die Bezeichnung „Künstliche Intelligenz“ hebt die Erwartungen an diese Systeme, indem sie suggeriert, dass sie menschliche Denkprozesse replizieren oder sogar eine Form des Bewusstseins oder der Empfindungsfähigkeit erreichen könnten.

Aber ist es Intelligenz?

Der Begriff „Künstliche Intelligenz“ wurde erstmals 1956 auf der Dartmouth-Konferenz geprägt und markierte den Beginn der KI als eigenständiges Feld. Dies stand im Gegensatz zu „Kybernetik“, einem von Norbert Wiener eingeführten Begriff, der die Studie der Steuerung und Kommunikation bei Tieren und Maschinen beschreibt, mit einem Fokus auf Rückkopplungsmechanismen und Systemregulierung statt der Nachahmung menschlichen Denkens. Die Vorliebe für KI gegenüber Kybernetik unterstrich einen Wandel hin zur Schaffung von Maschinen, die unabhängig denken und Entscheidungen treffen können, ein Vorhaben, das mit großem Potenzial und ethischen Fragestellungen beladen ist. Diese grundlegende Entscheidung ließ eine Zukunft erahnen, in der Maschinen nicht nur menschliche Fähigkeiten erweitern, sondern auch unsere Vorstellungen von Intelligenz, Bewusstsein und Leben herausfordern.

Die Auswahl von „Künstlicher Intelligenz“ über Alternativen wie „Kybernetik“ markierte eine bedeutende philosophische Abweichung in der Entwicklung der Computertechnologien. Es war mehr ein Kampf der Anziehungskraft als der Logik, wobei „AI“ sich als griffigeres Akronym erwies – ich mag es, immerhin sind das meine Initialen… Siebzig Jahre nachdem Wiener mit der Kybernetik experimentierte, scheint dieser Begriff eine passendere Beschreibung der Entwicklung zu sein für die große Sprachmodelle wie Chat GPT stehen – und dennoch ist die Entwicklungsreise noch lange nicht abgeschlossen, selbst wenn wir die Grenzen von vom Menschen generierten Trainingsdaten erreichen.

Wenn heute über „Denken“ diskutiert wird, geht es nicht um den Denkprozess im hegelschen Sinne, sondern eher um einen Rechenprozess des Sortierens, Verarbeitens und Analysierens von Daten. Jahrhundertelang haben Wissenschaft und Philosophie gerungen, um zu verstehen, was den Funken des Entstehens eines Gedankens entzündet, eine Debatte, die ungelöst bleibt. Wenn Intelligenz als emergentes Phänomen und Datenverarbeitung definiert wird, und nicht per se als eine menschliche Eigenschaft, dann bedeutet ihre technologische Replikation auch die Replikation des Menschlichen. Kurz gesagt, wenn unsere Gehirne nur rechnerisch und Teil eines physischen Systems sind, dann könnten Computer theoretisch jede menschliche Fähigkeit nachbilden.

Wenn künstliche allgemeine Intelligenz (AGI) menschliche Fähigkeiten erreichen oder übertreffen soll, werden wir mit einer paradoxen Situation konfrontiert, in der die Unterscheidung zwischen Mensch und Maschine undefiniert sein wird. Wenn Computer alles nachbilden können, was Menschen zu tun imstande sind, dann verwischt die Linie zwischen dem, was natürlich menschlich ist, und dem, was künstlich erschaffen wurde. Die ultimative Implikation ist, dass wir in der Lage sein müssen, Computeroperationen von menschlicher Kognition zu unterscheiden – denn ohne die Fähigkeit, den Unterschied genau zu erklären, wird die Unterscheidung zwischen einer Replik und dem Original unmöglich, eine Überlegung, die besonders relevant wird, wenn man die Verschmelzung mit KI betrachtet. Wenn eine Entität bewusst ist, könnten wir dies möglicherweise nie erkennen, eine Realität, die bereits in Interaktionen mit fortgeschrittenen KI-Systemen und in unserem Verständnis von Bewusstsein bei Menschen vorhanden ist. Da wir nicht vollständig verstehen, was Bewusstsein ausmacht, können wir es heute in anderen Lebewesen nicht definitiv feststellen; wenn wir wissenschaftlich klären könnten, was Bewusstsein beinhaltet, könnte es theoretisch repliziert werden. Dieses Argument gilt nicht nur für das Ausführen von Aufgaben oder das Verarbeiten von Informationen, sondern auch für das Zeigen einer breiten Palette von Emotionen, intuitiven Reaktionen und ethischem Denken, die zumindest theoretisch in Maschinen simuliert oder repliziert werden könnten. Wenn die Technologie das Verständnis von Bewusstsein und dem menschlichen Geist nachbilden kann, stehen wir möglicherweise vor einer dystopischen Zukunft, in der wir zu dem werden, was ich ‚Homo Obsoletus‘ nenne. Dieses Thema wird ausführlich in unserem Buch ‚The Singularity Paradox – Bridging the Gap between Humanity and AI‘ behandelt, das Anfang 2025 erscheinen wird und das ich zusammen mit Dr. Florian Neukart geschrieben habe.

Dies wirft ethische Dilemmata und moralische Implikationen auf bezüglich der Schaffung von Entitäten, die die menschliche Intelligenz übertreffen und möglicherweise Bewusstsein besitzen könnten, einschließlich Debatten über die Rechte von KI, die Verantwortlichkeiten der Schöpfer und die globalen Auswirkungen ihrer Entscheidungen – Aspekte, die in anderen Publikationen behandelt werden.

Im griechischen Mythos ist Narziss von seinem eigenen Bild gefesselt. In dem, was ich als ‘letzte narzisstische Kränkung’ beschreibe, bleibt das Spiegelbild bestehen, aber es gibt kein Selbst mehr, das es erkennen könnte – der ultimative Verlust der Selbstwahrnehmung. Doch was würde das bedeuten? Wenn niemand da ist, um wahrzunehmen, können wir dann überhaupt die Existenz einer Dystopie diskutieren?

Was einem solchen Argument folgt, ist, dass wir ein Verständnis dafür benötigen, wie eine künstlich intelligente und potenziell bewusste Entität funktioniert. Aus philosophischer und wissenschaftlicher Sicht besteht die gemeinsame Herausforderung darin, anzuerkennen, dass diese Entitäten sich von einem Menschen unterscheiden, ohne zu wissen, wie. So scheint mir der Ausweg über eine vereinfachte Antwort zu lauten: Die Frage, was es bedeutet, ein Mensch zu sein, muss für immer unbeantwortet bleiben.

Der Weg zur Singularität

Kurzweils Prognosen einer ‚Technologischen Singularität bis 2045‘ – einer Zukunft, in der künstliche Intelligenz den Menschen als die intelligentesten Entitäten auf der Erde übertrifft – galten einst als fantasievolle, der Science-Fiction zugehörige Vorstellungen, die einem fernen Morgen zugeordnet wurden. Doch während wir uns diesen Daten nähern, scheinen die Jahre 2029 und 2045 nicht mehr weit entfernt. Angesichts dessen wächst meine Überzeugung – die kapitalistischen und wirtschaftlichen Chancen beiseite gelassen – dass das Meistern der Kunst, „die Zukunft zu antizipieren“, wenn nicht die wichtigste, so doch eine der entscheidenden Fähigkeiten ist, die wir entwickeln müssen, um in eine für viele unvorstellbare Zukunft zu navigieren. Heute ist die relevante Frage nicht, ob etwas machbar ist, sondern welche Art von Zukunft wir wünschen. Wenn alles Denkbare theoretisch möglich ist, tragen wir eine tiefe Verantwortung. Gibt es andererseits Grenzen, müssen wir diese vollständig verstehen, um potenzielle Zukünfte genau vorherzusagen und das Reich der Möglichkeiten zu begreifen.

Können wir dann effektiv zukünftige Szenarien vorhersehen, indem wir den aktuellen und historischen Verlauf der Technologie betrachten und diese Trends in hypothetische Zukünfte extrapolieren? Wie können wir unsere Voraussicht darüber verbessern, was bevorstehen könnte?

Eine praktische Übung könnte darin bestehen, Kurzweils „Law of Accelerating Returns ( Gesetz der beschleunigenden Erträge)“ zu studieren. Durch die Reflexion über dieses Modell können wir hinterfragen und diskutieren, was wir für das plausibelste Ergebnis halten.

Kurzweil argumentiert, dass der technologische Fortschritt mit einer nahezu konstanten Geschwindigkeit voranschreitet, unbeeindruckt von äußeren Störungen wie Kriegen oder wissenschaftlichen Durchbrüchen. Seit über vierzig Jahren dokumentiert er dieses Phänomen in seiner „Preis-Leistungs-Rechnung“-Tabelle, die bis zu Konrad Zuses erstem Computer im Jahr 1939 zurückreicht, der lediglich 0,00007 Berechnungen pro Dollar pro Sekunde durchführte. In seinem neuesten Update von 2023 merkt Kurzweil an, dass wir 35 Milliarden Berechnungen pro Dollar erreicht haben – ein erstaunlicher Anstieg um das zwanzig Billiardenfache in achtzig Jahren.

In ‚The Singularity Paradox‘ werfen wir einen tieferen Blick auf die potenziellen Implikationen einer solchen technologischen Singularität. Diese Diskussion ist entscheidend, da wir uns kritischen Wendepunkten nähern, an denen ‘ Zukunft’ nicht mehr als fernes Gespenst, sondern als unmittelbare Realität mit greifbaren und weitreichenden Konsequenzen erscheint.

Betrachten wir für einen Moment Kurzweils Grafik. Was glaubst du?

Mich interessieren besonders Szenarien, in denen du keinen Fortschritt siehst. Teile deine Gedanken gerne als Kommentar unten mit.

Unsere Zukunftsaussichten können auf mindestens drei Arten charakterisiert werden:

- Wir glauben, dass sich der Fortschritt weiterhin exponentiell beschleunigen wird, wie es die letzten 80 Jahre gezeigt haben.

- Wir glauben, dass wir ein Plateau des Fortschritts erreicht haben; wenn ja, was führt uns zu dieser Schlussfolgerung?

- Wir glauben, dass eine Regression möglich ist, oder dass externe Kräfte unsere technologischen Fortschritte zunichtemachen könnten; was könnte eine solche Regression antreiben?

Es gibt viele starke Behauptungen über die Grenzen wissenschaftlicher Durchbrüche und das Ende des wirtschaftlichen Wachstums, die Investitionen ersticken würden. Es scheint jedoch mindestens gleichermaßen plausibel, dass dieser Weg des Fortschritts noch einige Jahre anhalten könnte, oder zumindest ist es schwierig, diese Möglichkeit vollständig auszuschließen.

Dies führt uns zu meinem Punkt über antizipierte Zukünfte. In der heutigen Gesellschaft erreichen Diskussionen oft eine Sackgasse, da Ansichten polarisiert und statisch sind, ohne die dynamische Natur der Welt zu würdigen. Aber der Kern der Sache ist nicht, wer recht hat; es geht darum zu verstehen, was deine Position für dich bedeutet.

Wenn du ein Szenario des Fortschritts kategorisch ausschließen kannst, dann kannst du deine Strategien entsprechend ausrichten. Andernfalls wird es wesentlich, verschiedene zukünftige Szenarien zu antizipieren, um auf mögliche Ergebnisse vorbereitet zu sein. Wenn du glaubst, dass der Fortschritt weitergeht, was bedeutet das? Welche potenziellen Geschäftsmodelle könnten entstehen? Welche Implikationen könnte dies für die Menschheit haben? Ist dies eine Zukunft, die es wert ist, angestrebt und gelebt zu werden?

Zurückblickend auf das Jahr 2017, was einst als Science-Fiction und spekulativer Futurismus abgetan wurde, hat sich überraschenderweise in Realismus verwandelt – vorausgesetzt, wir behalten den Bezug zur Realität. Jetzt, sieben Jahre später, haben viele ihre Perspektiven geändert. Dennoch bleibt die Herausforderung, die Zukunft vorherzusagen, gewaltig. Betrachte zum Beispiel Elon Musks Rücktritt aus dem Vorstand von OpenAI, den Sam Altman darauf zurückführte, dass die Organisation in der Entwicklung zurückgeblieben sei. Zwei Jahre nach der sogenannten ‘Intelligenz-Explosion’, angetrieben durch große Sprachmodelle (LLMs), finden wir uns nun in einer Phase des Erstaunens und der Unordnung wieder. Entwicklungen in der KI haben sich unerwartet beschleunigt, was die marginalen Kosten der Intelligenz drastisch sinken ließ.

Kurzweil erweitert diese Idee des exponentiellen Fortschritts über das Verständnis menschlicher Sprache hinaus auf fast alle technologischen Ereignisse und schlägt vor, dass ein passenderer Begriff „Große Ereignismodelle“ (Large Event Models, LEMs) sein könnte. Diese Überarbeitung hebt die breite Anwendbarkeit und Auswirkung dieser Entwicklungen hervor.

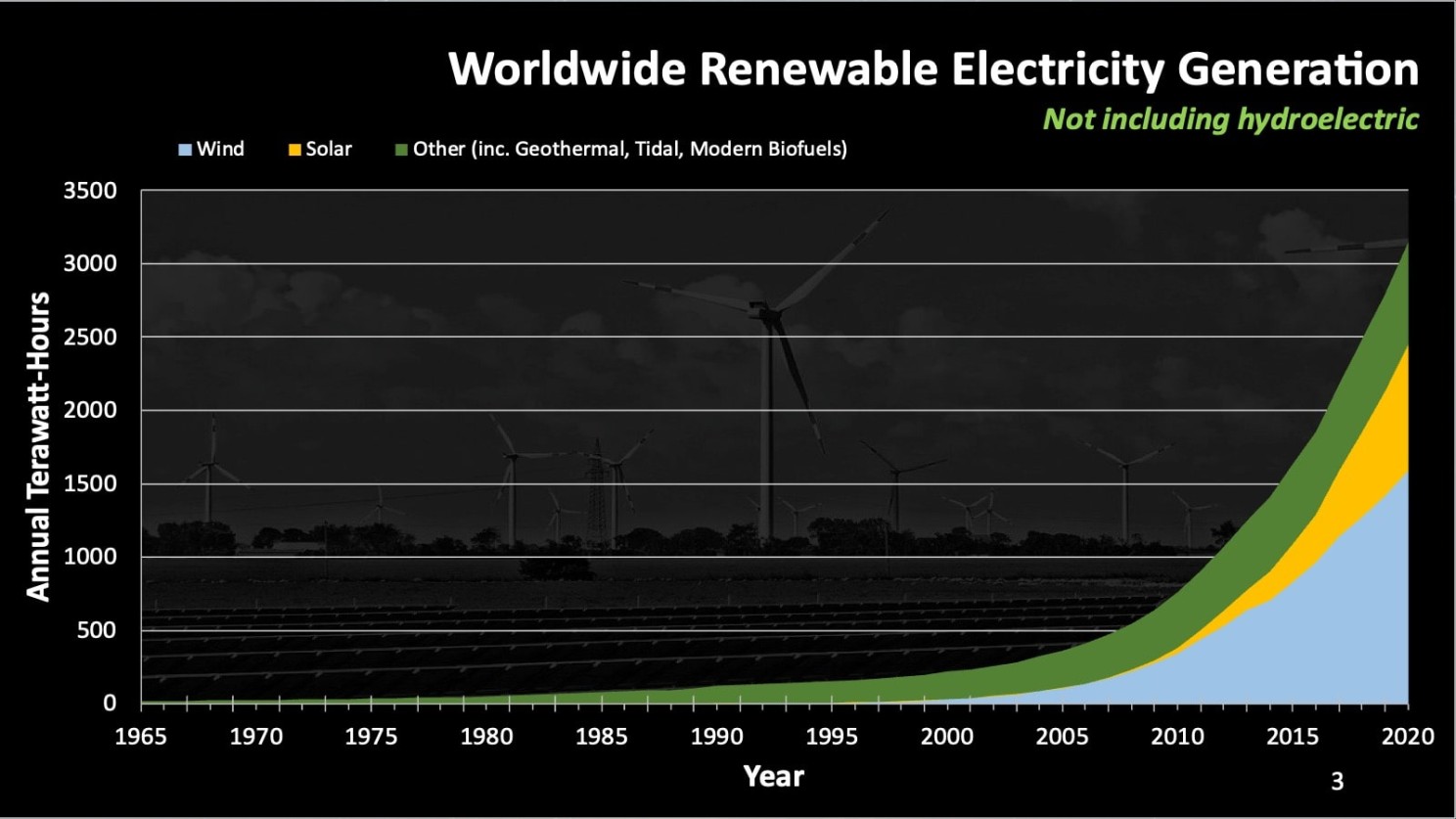

Betrachten wir einmal das exponentielle Wachstum erneuerbarer Energien als illustratives Beispiel. Die nächsten 2-3 Jahre werden voraussichtlich einen signifikanten Anstieg der Nachfrage aufgrund der Elektrifizierung und erhöhten Rechenanforderungensehen. Prognosen variieren von einer Verdopplung bis zu einer Verdreifachung der Nachfrage. Bei solch einem Druck werdensicherlich Investitionen folgen, neue Geschäftsmodelle entstehen und wissenschaftliche Fortschritte werden erzielt.

Seit Jahren behaupte ich, dass die marginalen Kosten für Energie, ähnlich wie bei der Intelligenz, innerhalb nun des nächsten Jahrzehnts auf nahezu Null sinken werden, angetrieben durch den unermüdlichen Fortschritt in den Bereichen Solar- und Windenergie. Wir haben kein Energieproblem, wir haben ein Speicher- und Distributionsproblem. Obwohl die Reise ihren Anteil an Hype und anschließenden Enttäuschungen haben mag, sind Durchbrüche wahrscheinlich unvermeidlich und werden den Markt disruptieren und neue Möglichkeiten schaffen.

Dieses Muster ähnelt den exponentiellen Trends, wie sie typischerweise beim technologischen Fortschritt zu beobachten sind. Oder siehst du irgendwelche Gründe, warum dieser Fortschritt plötzlich zum Stillstand kommen könnte?

Meine Prognose ist klar. Fossile Brennstoffe werden nicht ausgehen – sie werden einfach nicht mehr wettbewerbsfähig sein.

Können wir eine solche Entwicklung mit Sicherheit vorhersagen?

Nein. Wir können jedoch von führenden Unternehmen in diesen Bereichen lernen und technologische Fortschritte verstehen, um zukünftige Entwicklungen besser zu antizipieren. Aktuelle Diskussionen um Kernenergie, zusätzliche Kohle und ‚Slow-Tech‘ scheinen für mich weniger vielversprechende Wege zu sein.

Zukünfte antizipieren: Eine Frage des Willens und der Möglichkeiten

Es gibt zahlreiche Debatten und Beispiele, die unsere potenziellen Zukünfte umgeben. Wird die Effizienz in der Technologie weiterhin verbessert? Können wir die Verteilungssysteme verbessern? Sind wir in der Lage, überlegene Energiespeicherlösungen zu entwickeln? Ich glaube, dass unsere Zukunft entschieden positiv sein kann, doch das hängt davon ab, ob wir bereit sind, das Potenzial exponentieller Technologien zu ergreifen, in menschliches Wachstum zu investieren und die notwendige Anstrengung zu unternehmen, um neue organisatorische und geschäftliche Modelle zu bauen und umzusetzen, die auf diese erwarteten Zukunftsszenarien zugeschnitten sind.

Letztlich läuft es auf die grundsätzliche Frage hinaus, was wir für möglich halten. Glauben wir an die Möglichkeit des Fortschritts? Wenn nicht, was sind die Gegenargumente und welche Konsequenzen ergeben sich daraus? Welche Maßnahmen sollten wir dann ergreifen? Umgekehrt, wenn wir glauben, dass Fortschritt erreichbar ist, was hält uns davon ab, diese Zukunft zu verfolgen und zu gestalten?

Einige mögen sich an eine göttliche Dimension klammern, indem sie auf einen deterministischen Fortschrittsglauben als eine tröstliche, wenn auch weniger anstrengende Art, die Welt zu verstehen, setzen. Für andere ist es der spannendere und lohnendere Weg, einen plausiblen und gerechtfertigten Glauben an die Art von Zukunft zu entwickeln, die geschaffen werden kann und es wert ist, angestrebt zu werden. Ich habe mich für letzteres entschieden und finde große Begeisterung in diesem Streben. Es scheint, dass die heutige Diskussion über die Zukunft weniger von Science-Fiction handelt und mehr von „Sci-Phi“ – einer Mischung aus wissenschaftlicher Untersuchung und philosophischer Erkundung, die darauf abzielt, potenzielle Zukünfte zu antizipieren und in die gewünschten Bahnen zu lenken.

Heute scheint ein passender Moment zu sein, ‚rückwärts zu blicken‘, um ‚nach vorne zu schauen‘ und möglicherweise eine klarere Perspektive des ‚Jetzt‘ zu gewinnen.

Im Wesentlichen wird die Zukunft mehr durch unsere Handlungen als durch unsere Einschränkungen geformt, da das Streben nach immer besseren Erklärungen und Fortschritten eine inhärente Kraft der Natur zu sein scheint, ob aus einer realistischen oder physikalistischen Perspektive betrachtet.

Dies wirft eine kritische Frage für die Menschheit auf, die auch auf individueller Ebene anwendbar ist: Wenn irgendeine Zukunft gebaut werden könnte, was würdest du bauen? Mit anderen Worten, welche Zukunft ist erstrebenswert?

Da wir uns Kurzweil’s Vorhersagen zufolge der technologischen Singularität nähern – einem Punkt, an dem technologisches Wachstum unkontrollierbar und irreversibel wird und die menschliche Zivilisation radikal verändert – wird klar, dass es unmöglich ist, spezifische Ergebnisse vorherzusagen. Diese Singularität deutet auf eine Zukunft hin, in der KI und andere Technologien die Beschäftigung, die Regierungsführung und die sozialen Strukturen tiefgreifend verändern könnten.

Während wir den 300. Geburtstag von Immanuel Kant feiern, sind wir aufgerufen, die Denker unserer Zeit zu werden. Die Philosophie wird sich in eine Praxis des bedachten Engagements verwandeln, wie Kant es einst vorsah, und sich auf den humanen Aspekt unserer Existenz konzentrieren, wie Kant ihn in der Bibel fand, während er gleichzeitig die gesamte Theologie herausforderte.

Was wird es also sein? Wird die KI-Entwicklung uns zu einer utopischen Realität, einem dystopischen Zusammenbruch oder einer Transformation der menschlichen Existenz führen, die unser aktuelles Verständnis übersteigt?

Diskussionen darüber, wie die Menschheit Möglichkeiten navigieren kann, um eine Zukunft zu sichern, die unseren Bestrebungen entspricht, sind notwendig. Kurz gesagt: Können wir lernen, wie man ‘Zukunft antizipiert‘?

Ich freue mich auf deine Gedanken und Anregungen!