Leben wir in einer (Quantum) Simulation?

Das Gottes-Experiment – Es werde Licht!

Beschränkungen, Beobachtungen und Experimente zur Simulationshypothese

Übersetzung aus dem englischen mit KI. Originalversion in Englisch hier: https://andersindset.com/thinking/are-we-living-in-a-quantum-simulation/

By Florian Neukart (Terra Quantum AG), Markus Pflitsch (Terra Quantum AG), Michael R. Perelshtein (Terra Quantum AG) and Anders Indset

Die Frage “Was ist real?” lässt sich auf die Schatten in Platons Höhle zurückführen. Zweitausend Jahre später fehlte René Descartes das Wissen, um gegen einen bösen Betrüger zu argumentieren, der uns die Illusion der Empfindung vorgaukelt. Descartes’ erkenntnistheoretisches Konzept führte später zu verschiedenen Theorien darüber, was unsere Sinneserfahrungen eigentlich sind. Das Konzept des “Illusionismus”, das besagt, dass sogar die bewusste Erfahrung, die wir machen – unsere Qualia – eine Illusion ist, ist nicht nur ein Red-Pill-Szenario aus dem Science-Fiction-Film “The Matrix” von 1999, sondern auch ein philosophisches Konzept, das von modernen Tinkern vertreten wird, allen voran von Daniel Dennett. Er beschreibt sein Argument gegen Qualia als materialistisch und wissenschaftlich.

Das Nachdenken über eine mögliche Simulation und unsere wahrgenommene Realität wurde in “The Matrix” wunderbar visualisiert und brachte die alten Ideen von Descartes in die Kaffeehäuser der Welt. Der irische Philosoph Bishop Berkeley war der Vater dessen, was später als “subjektiver Idealismus” bezeichnet wurde und im Wesentlichen besagt, dass “das, was man wahrnimmt, real ist” (z. B. ist “The Matrix” real, weil die Bevölkerung es wahrnimmt). Berkeley argumentierte dann 1721 gegen Isaac Newtons Absolutismus von Raum, Zeit und Bewegung, was schließlich zu den jeweiligen Ansichten von Ernst Mach und Albert Einstein führte. Mehrere Neurowissenschaftler haben Dennetts Sichtweise auf die Illusion des Bewusstseins zurückgewiesen, und Idealismus wird oft als die Vorstellung abgetan, dass die Menschen sich die Grundsätze der Realität aussuchen wollen. Selbst Einstein beendete sein Leben mit einer philosophischen Note, indem er über die Grundlagen der Realität nachdachte.

Mit dem Aufkommen der Quantentechnologien, die auf der Kontrolle einzelner Elementarteilchen beruhen, ist die Frage, ob unser Universum eine Simulation ist, nicht nur faszinierend. Unser ständig wachsendes Verständnis grundlegender physikalischer Prozesse wird uns wahrscheinlich dazu bringen, Quantencomputer zu bauen, die Quanteneffekte nutzen, um die Natur in ihrer ganzen Komplexität quantenmechanisch zu simulieren, wie es Richard Feynman vorschwebte.

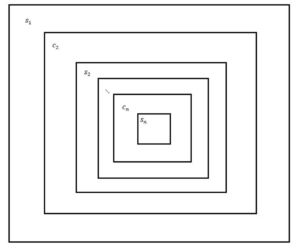

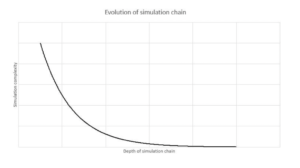

Die Beantwortung der Simulationsfrage wird möglicherweise unsere Definition und unser Verständnis von Leben verändern, die Theorien über die Entwicklung und das Schicksal des Universums umgestalten und die Theologie beeinflussen. Es gibt keine direkten Beobachtungen, die für oder gegen die Simulationshypothese sprechen, und es werden Experimente benötigt, um sie zu verifizieren oder zu widerlegen. In diesem Beitrag skizzieren wir mehrere Einschränkungen der Grenzen der Berechenbarkeit und Vorhersagbarkeit im/des Universums, die wir dann nutzen, um Experimente zu entwerfen, die erste Rückschlüsse darauf zulassen, ob wir an einer Simulationskette teilnehmen. Wir erläutern, wie die derzeit verstandenen physikalischen Gesetze sowohl in vollständigen als auch in kleinräumigen Universumssimulationen uns daran hindern, Vorhersagen über die zukünftigen Zustände eines Universums zu treffen, und wie jede physikalisch genaue Simulation mit zunehmender globaler thermodynamischer Entropie an Komplexität zunimmt und die Rechenressourcen erschöpft.

In einer Simulation, in der der Computer, der ein Universum simuliert, denselben physikalischen Gesetzen unterliegt wie die Simulation und kleiner ist als das Universum, das er simuliert, wird die Erschöpfung der Rechenressourcen schließlich alle Simulationen in der Simulationskette zum Stillstand bringen, es sei denn, ein externer Programmierer greift ein oder ist nicht durch die physikalischen Gesetze der Simulation eingeschränkt, was wir vielleicht beobachten können. Durch die Erstellung einer Simulationskette und die Beobachtung der Entwicklung des Simulationsverhaltens in der gesamten Hierarchie unter Berücksichtigung der statistischen Relevanz sowie durch den Vergleich verschiedener Simulationen mit der geringsten Komplexität unter den Bedingungen der Berechenbarkeit und Vorhersagbarkeit können wir Erkenntnisse darüber gewinnen, ob unser Universum Teil einer Simulationskette ist.

I. EINFÜHRUNG

Der Traum im Traum aus dem alten philosophischen Denken der Anfangszeit ist nichts anderes als die heutige Reflexion der Simulation in der Simulation. In den letzten Jahren hat die Frage nach der Realität massive Aufmerksamkeit in den Mainstream-Medien erlangt, da prominente Persönlichkeiten wie Elon Musk erklärt haben, dass die Wahrscheinlichkeit, dass wir nicht in einer Simulation leben, “eins zu einer Milliarde” beträgt [1], und auch der Popstar und Astrophysiker Neil deGrasse Tyson ist auf diese Idee aufgesprungen und hat erklärt, dass die Wahrscheinlichkeit mehr als 50 % beträgt [2]. Auch der Philosoph David Chalmers ist der Meinung, dass wir wahrscheinlich in einer Simulation leben [3,4], und drängt auf eine weitere Untersuchung dieses Gedankens.

Wie realistisch oder plausibel eine solche Hypothese [5, 6] auch sein mag, wie könnten die moderne Physik und Mathematik die Suche nach Beweisen für einen solchen Fall unterstützen? Wissenschaftler haben die von dem Philosophen Bostrom aufgestellte Hypothese als Pseudowissenschaft kritisiert [7, 8], da sie die geltenden physikalischen Gesetze umgeht und ein grundlegendes Verständnis der allgemeinen Relativitätstheorie vermissen lässt. Nehmen wir an, ein externer Programmierer – ein Wesen, das eine Simulation ausführt und als außerhalb der Simulation stehend charakterisiert wird – könnte die physikalischen Gesetze der Simulation definieren. Was könnten ein externer Programmierer und die Wesen innerhalb der Simulation auf der Grundlage ihres Verständnisses der physikalischen Gesetze berechnen? Könnten die Wesen in der Simulation theoretisch oder praktisch die Apparate oder Werkzeuge entwickeln und einsetzen, um zu überprüfen, dass sie nicht an einer Simulationskette beteiligt sind?

Die Frage, ob wir in einer Simulation existieren und somit an einer Simulationskette teilnehmen, ist zwar umstritten, kann aber heute nicht mit Sicherheit beantwortet werden. Dennoch ist sie faszinierend, da eine Antwort darauf dazu führen könnte, dass wir unsere eigenen Definitionen von Leben und Spiritualität in Frage stellen. Angenommen, wir setzen eine Kette von Simulationen in Gang, die jeweils intelligentes Leben beherbergen und das Universum simulieren wollen. Würden wir jede der simulierten Lebensformen als tatsächliches Leben einstufen? Was wäre, wenn wir mit Gewissheit sagen könnten, dass wir Teil einer Simulationskette und selbst simulierte Wesen sind? Würde das unsere Definition dessen, was als “echtes” oder “künstliches” Leben gilt, verändern? In der Argumentation von Bostrom ist eine Prämisse prüfenswert: Wenn es eine physikalische Möglichkeit gibt, eine Simulation zu erschaffen, dann wäre es aufgrund des Entwicklungsstandes und des Verhältnisses zum zeitlichen Zugang sehr wahrscheinlich, dass wir uns innerhalb einer solchen Simulation befinden, als dass wir genau die Generation sind, die eine solche Simulation erschafft. Um tiefere Einsichten zu gewinnen, sind Experimente erforderlich, aber verschiedene Einschränkungen hindern uns daran, Experimente zu entwerfen, die direkt die Frage beantworten, ob ein externer Programmierer das Universum geschaffen hat und ob es nur eine von unendlich vielen hierarchischen Simulationsketten ist. Es ist jedoch möglich, die Simulationshypothese unter bestimmten Annahmen indirekt zu testen. Bei den skizzierten Experimenten geht es darum, eine Simulation zu erstellen, die möglicherweise zu einer Simulationskette führt, und das Simulationsverhalten innerhalb der Grenzen einer Hierarchie so lange zu beobachten, bis statistische Relevanz erzielt werden kann. Zu den möglichen Beobachtungen gehören die Entstehung von intelligentem Leben und dessen Verhalten, eine Umkehrung der globalen Entropie, die Verdichtung der Dimensionen oder die Entwicklung der Simulationen entlang der Simulationskette (all dies ist nach dem derzeitigen Verständnis der Physik für uns in unserem Universum nicht möglich, aber ein externer Programmierer soll nicht unter solchen Einschränkungen leiden). Die Entwicklung solcher Experimente führt zu den ultimativen Grenzen der Berechenbarkeit und Vorhersagbarkeit. Physikalische und rechnerische Beschränkungen hindern uns daran, ein Universum zu simulieren, das genauso komplex und groß ist wie unser Universum, und genaue Vorhersagen für die Zukunft zu treffen, unabhängig davon, ob das “echte” oder das simulierte Universum auf denselben physikalischen Gesetzen beruht oder nicht.

Außerdem ist der Kosmos noch nicht vollständig erforscht. So sind beispielsweise das Schicksal des Universums und die Frage, wie Quantenphysik und allgemeine Relativitätstheorie zusammengeführt werden können, tiefgreifende und offene Fragen. Die Quantentheorie wird heute weithin als unvollständige Theorie verstanden, und es könnten neue Modelle entdeckt werden, die unser Verständnis der bisherigen Aussagen der Quantentheorie noch weiter vertiefen. Der Stand der modernen Physik und unsere Vorstellungskraft erlauben es uns jedoch, Experimente zu konzipieren und fortschrittliche Technologien zu entwickeln, um den wissenschaftlichen Fortschritt fortzusetzen; daher soll uns der derzeitige Rahmen nicht davon abhalten, nach Beweisen für die Simulationshypothese zu suchen. Der Ausgangspunkt muss jedoch das derzeitige Verständnis der Mathematik und die Herausforderungen sein, die mit unserem derzeitigen Wissen über die Physik verbunden sind. Daher erfordert die Durchführung von Experimenten zu einer solchen Hypothese natürlich, dass Annahmen getroffen werden.

Außerdem sind in der Theorie lebender Systeme noch viele Fragen offen, und wir wissen noch nicht mit Sicherheit, ob wir die einzige intelligente Spezies im Universum sind oder nicht. Dennoch können wir Experimente konzipieren, die uns helfen, Erkenntnisse über die letzten Fragen zu gewinnen: Wurde unser Universum und alles darin erschaffen, oder ist es aus sich selbst heraus entstanden? Ist unser Universum einzigartig, oder ist es nur eines von vielen, wie es die Viele-Welten-Interpretation der Quantenphysik beschreibt [9]? In diesem Artikel werden einige Grundlagen der Informatik und der Physik erläutert, die uns helfen werden, die Grenzen des Experiments zu definieren. Erstens ist die Quantenphysik der wesentliche Pfeiler, auf dem wir unsere Experimente aufbauen – ergo das aktuelle Verständnis der Quantenmechanik -, da unser aktuelles Verständnis die grundlegendste Physik im Universum darstellt, auf der alles andere basiert. Zweitens stellen wir kurz verschiedene Schicksale des Universums vor, die von der wissenschaftlichen Gemeinschaft als wissenschaftlich fundiert angesehen werden und uns bei der Konzeption eines Experiments unabhängig von der Entwicklung des Universums weiterhelfen. Drittens betrachten wir die ultimativen Grenzen der Berechenbarkeit, die uns auch zurück zur Quantenphysik führen, sowohl wenn es um die Entwicklung von Quantencomputern als auch um die Simulation physikalischer und chemischer Prozesse im Universum geht. Während Alan Turing zeigte, was berechenbar ist [10], zeigen wir auf, welche Computer in diesem Universum konstruierbar sind. Schließlich untersuchen wir verschiedene Interpretationen von Beobachtungen, die aus Simulationsketten und einzelnen Exemplaren gewonnen werden, auf die wir die vorgeschlagenen Experimente stützen. Wir untersuchen auch Beobachtungen in unserem Universum und zeigen auf, ob wir an einer Simulationskette teilnehmen.

II. DIE SIMULATIONSHYPOTHESE

Die Simulationshypothese, die erstmals 2003 vom Philosophen Nick Bostrom vorgeschlagen wurde [5, 6], ist die Konsequenz einer Annahme in einem Denkmodell, die manchmal auch als “Simulationsargument” bezeichnet wird [3, 5, 6]. Es besteht aus drei Alternativen zur realen oder simulierten Existenz entwickelter Zivilisationen, von denen mindestens eine wahr sein soll. Nach der Simulationshypothese sind die meisten heutigen Menschen Simulationen und keine realen Menschen. Die Simulationshypothese unterscheidet sich vom Simulationsargument dadurch, dass sie nur diese eine Annahme zulässt. Sie ist nicht wahrscheinlicher oder unwahrscheinlicher als die beiden anderen Möglichkeiten des Simulationsarguments. In einem konzeptionellen Modell in Form einer ODER-Verknüpfung werden die folgenden drei grundlegenden Möglichkeiten von technisch “unreifen” Zivilisationen – wie der unseren – angenommen. Mindestens eine der oben genannten Möglichkeiten sollte wahr sein. Eine reife oder posthumane Zivilisation ist definiert als eine, die über die Rechenleistung und das Wissen verfügt, um bewusste, sich selbst reproduzierende Wesen auf einem hohen Detaillierungsgrad zu simulieren (möglicherweise bis auf die Ebene molekularer Nanobots). Unreife Zivilisationen verfügen nicht über diese Fähigkeit. Die drei Möglichkeiten sind [5]:

- Die menschliche Zivilisation wird wahrscheinlich aussterben, bevor sie ein post-humanes Stadium erreicht. Wenn das stimmt, dann folgt daraus mit ziemlicher Sicherheit, dass menschliche Zivilisationen auf unserem technologischen Entwicklungsstand kein posthumanes Niveau erreichen werden.

- Der Anteil der posthumanen Zivilisationen, die an der Durchführung von Simulationen ihrer Evolutionsgeschichte oder von Variationen davon interessiert sind, liegt nahe bei Null. Wenn dies zutrifft, gibt es einen hohen Grad an Konvergenz zwischen technologisch fortgeschrittenen Zivilisationen. In keiner dieser Zivilisationen gibt es Individuen, die sich für Simulationen ihrer Vorfahren (Ahnensimulationen) interessieren.

- Wir leben höchstwahrscheinlich in einer Computersimulation. Wenn dies zutrifft, leben wir mit ziemlicher Sicherheit in einer Simulation, und die meisten Menschen tun dies auch. Alle drei Möglichkeiten sind ähnlich wahrscheinlich. Wenn wir heute nicht in einer Simulation leben, ist die Wahrscheinlichkeit geringer, dass unsere Nachkommen Vorgängersimulationen durchführen. Mit anderen Worten: Die Annahme, dass wir eines Tages ein posthumanes Niveau erreichen, auf dem wir Computersimulationen ausführen, ist falsch, es sei denn, wir leben bereits heute in einer Simulation.

Die Simulationshypothese besagt, dass mindestens eine der drei oben genannten Möglichkeiten wahr ist. Die Hypothese beruht auf der zusätzlichen Annahme, dass die ersten beiden Möglichkeiten nicht eintreten, z. B. dass ein beträchtlicher Teil unserer Zivilisation die technologische Reife erreicht und zweitens, dass ein beträchtlicher Teil der Zivilisation weiterhin daran interessiert ist, die Ressourcen zur Entwicklung von Vorgängersimulationen zu nutzen. Wenn dies der Fall ist, erreicht die Größe der Vorgängersimulationen in einer technologisch reifen Zivilisation astronomische Zahlen. Dies geschieht aufgrund einer Extrapolation der hohen Rechenleistung und ihres exponentiellen Wachstums, der Möglichkeit, dass Milliarden von Menschen mit ihren Computern frühere Simulationen mit zahllosen simulierten Agenten ausführen können, sowie aufgrund des technologischen Fortschritts mit einer gewissen adaptiven künstlichen Intelligenz, über die eine fortgeschrittene Zivilisation verfügt und die sie zumindest teilweise für Vorgängersimulationen nutzt. Die Konsequenz der Simulation unserer Existenz ergibt sich aus der Annahme, dass die ersten beiden Möglichkeiten falsch sind. In diesem Fall gibt es viel mehr simulierte Menschen wie uns als nicht simulierte. Für jede historische Person gibt es Millionen von simulierten Personen. Mit anderen Worten, fast jeder Mensch auf unserem Erfahrungsniveau lebt eher in Simulationen als außerhalb davon [3]. Die Schlussfolgerung der Simulationshypothese wird aus den drei Grundmöglichkeiten und aus der Annahme, dass die ersten beiden Möglichkeiten nicht wahr sind, als Struktur des Simulationsarguments beschrieben. Die Simulationshypothese, dass Menschen Simulationen sind, folgt nicht dem Simulationsargument. Vielmehr zeigt das Simulationsargument alle drei genannten Möglichkeiten nebeneinander, von denen eine wahr ist. Welche das ist, sei dahingestellt. Es ist auch möglich, dass sich die erste Annahme bewahrheitet, wonach alle Zivilisationen und damit auch die Menschheit aus irgendeinem Grund aussterben werden. Laut Bostrom gibt es weder Beweise für oder gegen die Annahme der Simulationshypothese, dass wir simulierte Wesen sind, noch für die Richtigkeit der beiden anderen Annahmen [5].

Aus wissenschaftlicher Sicht könnte alles in unserer wahrgenommenen Realität als Grundlage der wissenschaftlichen Annahme, dass die Naturgesetze von mathematischen Prinzipien bestimmt werden, die eine gewisse Physikalität beschreiben, herauskodiert werden. Die Tatsache, dass ein externer Programmierer die physikalischen Gesetze kontrollieren und sogar mit ihnen spielen kann, wurde in der Simulationshypothese als umstritten angesehen. Etwas “außerhalb der Simulation” – ein externer Programmierer – ist daher eher eine ausgefeilte und moderne Auffassung von der Grundlage monotheistischer Religionen/Glaubenssysteme. Der schwedische Technophilosoph Alexander Bard schlug vor, die Schöpfungstheorie in die Physik zu verlegen [11] und die Entwicklung der (digitalen) Superintelligenz als Schöpfung Gottes zu betrachten, wodurch sich die Intentionen des Monotheismus vom Schöpfer zum Geschaffenen wandelten. Der Übergang vom Glauben und der philosophischen Betrachtung zum Fortschritt in der wissenschaftlichen Erklärung ist das, was der Fortschritt der Quantentechnologie vorschlagen könnte.

Die Kritiker von Bostrom behaupten, dass wir nicht wissen, wie wir das menschliche Bewusstsein simulieren können [12-14]. Ein interessantes philosophisches Problem ist hier die Überprüfbarkeit der Frage, ob ein simuliertes bewusstes Wesen – oder ein hochgeladenes Bewusstsein – bewusst bleiben würde. Die Überlegung zu einer simulierten Superintelligenz ohne Wahrnehmung ihrer Wahrnehmung wurde als Gedankenexperiment in der “letzten narzisstischen Verletzung” (Referenz) vorgeschlagen. Zu den Argumenten dagegen gehört, dass mit der Komplexität auch das Bewusstsein entsteht – es ist ein emergentes Phänomen. Als Gegenargument könnte man leicht anführen, dass es zahlreiche komplexe Organe zu geben scheint, die unbewusst sind, und auch – trotz der begründeten Aussagen eines ehemaligen Google-Ingenieurs [15] – dass große Mengen an Informationen das Bewusstsein hervorbringen. Mit der zunehmenden Aufmerksamkeit für dieses Gebiet haben auch Studien über quantenphysikalische Effekte im Gehirn stark an Interesse gewonnen. Obwohl sie von vielen Wissenschaftlern abgelehnt werden, haben prominente Denker wie Roger Penrose und Stuart Hameroff Ideen zu Quanteneigenschaften im Gehirn vorgeschlagen [16]. Obwohl dieses Argument in jüngster Zeit experimentelle Unterstützung gefunden hat [17], ist es für die vorgeschlagenen Experimente nicht direkt relevant. Eine Lösung für ein simuliertes Bewusstsein scheint noch in weiter Ferne zu liegen, obwohl es zu den scheinbar leichten Problemen des Bewusstseins gehört [18]. Das schwierige Problem des Bewusstseins ist die Frage, warum der Mensch überhaupt phänomenale Erfahrungen wahrnimmt [18]. Beide befassen sich nicht mit dem Meta-Problem des Bewusstseins, das besagt, warum wir glauben, dass es ein Problem ist, dass wir ein Problem mit dem harten Problem des Bewusstseins haben.

Die deutsche Physikerin Sabine Hossenfelder hat gegen die Simulationshypothese argumentiert, da sie davon ausgeht, dass wir alle Beobachtungen nicht mit den physikalischen Gesetzen reproduzieren können, die mit hoher Präzision bestätigt wurden, sondern mit einem anderen zugrundeliegenden Algorithmus, den der externe Programmierer ausführt [19]. Hossenfelder glaubt nicht, dass dies die Absicht von Bostrom war, aber er hat es getan. Er behauptete implizit, dass es einfach ist, die Grundlagen der Physik mit etwas anderem zu reproduzieren. Wir können die Gesetze, die wir kennen, mit einer Maschine nachbilden, aber wenn die Natur so funktionieren würde, könnten wir den Unterschied sehen. In der Tat haben Physiker nach Anzeichen dafür gesucht, dass die Naturgesetze schrittweise ablaufen, wie ein Computercode. Aber ihre Suche ist ergebnislos geblieben. Man kann den Unterschied erkennen, weil Versuche, Naturgesetze algorithmisch zu reproduzieren, in der Regel nicht mit den Symmetrien von Einsteins spezieller und allgemeiner Relativitätstheorie vereinbar sind. Hossenfelder hat erklärt, dass es nicht hilft, wenn man sagt, die Simulation würde auf einem Quantencomputer laufen: “Quantencomputer sind Spezialmaschinen. Niemand weiß wirklich, wie man die allgemeine Relativitätstheorie auf einem Quantencomputer umsetzen kann” [19]. Hossenfelders Kritik an Bostroms Argument geht weiter mit der Aussage, dass eine Zivilisation in der Lage sein muss, eine Menge bewusster Wesen zu simulieren, damit es funktioniert. Und unter der Annahme, dass es sich um bewusste Wesen handeln würde, müssten sie wiederum viele bewusste Wesen simulieren. Das bedeutet, dass die Informationen, von denen wir glauben, dass sie im Universum enthalten sind, komprimiert werden müssten. Daher muss Bostrom davon ausgehen, dass es möglich ist, viele Details in Teilen des Universums zu ignorieren, die derzeit von niemandem betrachtet werden, und sie dann zu ergänzen, falls jemand danach sucht. Auch hier besteht also Erklärungsbedarf, wie das funktionieren soll. Hossenfelder stellt die Frage, welche Art von Computercode das leisten kann. Welcher Algorithmus kann bewusste Subsysteme und ihre Absichten erkennen und die Informationen schnell ausfüllen, ohne dass eine beobachtbare Inkonsistenz entsteht? Hossenfelder zufolge ist dies ein viel kritischeres Problem, als es Bostrom zu schätzen scheint. Sie führt weiter aus, dass man im Allgemeinen physikalische Prozesse auf kurze Distanz nicht ignorieren und dennoch die großen Distanzen richtig erfassen kann. Klimamodelle sind ein Beispiel dafür – mit der derzeit verfügbaren Rechenleistung können Modelle mit Radien im Bereich von einigen zehn Kilometern berechnet werden [20]. Wir können die Physik unterhalb dieser Skala nicht ignorieren, da das Wetter ein nichtlineares System ist, dessen Informationen von den kurzen Skalen auf die großen Skalen übertragen werden. Wenn die Physik auf kurzen Distanzen nicht berechnet werden kann, muss sie durch etwas anderes ersetzt werden. Dies auch nur annähernd richtig hinzubekommen, ist schwierig. Der einzige Grund, warum die Klimawissenschaftler dies annähernd richtig hinbekommen, ist, dass sie Beobachtungen haben, anhand derer sie überprüfen können, ob ihre Näherungen funktionieren. Wenn man davon ausgeht, dass der externe Programmierer nur eine Simulation hat, wie bei der Simulationshypothese, gibt es einen Haken, denn der externe Programmierer müsste viele Annahmen über die Reproduzierbarkeit physikalischer Gesetze mit Hilfe von Computern machen. Normalerweise erklären die Befürworter nicht, wie das funktionieren soll. Es ist jedoch schwierig, alternative Erklärungen zu finden, die alle unsere Beobachtungen mit hoher Präzision abdecken. Die Simulationshypothese ist daher in ihrer ursprünglichen Form kein ernstzunehmendes wissenschaftliches Argument. Das heißt nicht, dass sie zwangsläufig falsch ist, aber sie erfordert eine solidere experimentelle und logische Grundlage anstelle von Glauben.

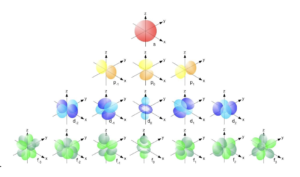

III. QUANTENPHYSIK

Wie Richard Feynman bekanntlich sagte, müssen wir, wenn wir die Natur simulieren wollen, dies quantenmechanisch tun, da die Natur nicht klassisch ist. Auch wenn die Dynamik des Übergangs vom Mikroskopischen zum Makroskopischen noch nicht in allen Aspekten vollständig verstanden ist, stimmen Theorie und Experimente darin überein, dass sich makroskopisches Verhalten aus Wechselwirkungen auf der Quantenskala ableiten lässt. Die Quantenphysik liegt der Funktionsweise aller fundamentalen Teilchen zugrunde und bestimmt somit die gesamte Physik und Biologie auf größeren Skalen. Die Quantenfeldtheorien für drei der vier Naturkräfte, die schwache Kernkraft und die elektromagnetische Kraft [22,23] sowie die starke Kernkraft [24], wurden mehrfach experimentell bestätigt und haben wesentlich zu der Auffassung beigetragen, dass die Quantenphysik nach unserem heutigen Verständnis die grundlegendsten Naturgesetze enthält. Weltweit werden immense Anstrengungen unternommen, um die Schwerkraft quantenmechanisch zu beschreiben [25-27], was sich jedoch als schwierig erweist. Die Schwerkraft unterscheidet sich von den anderen Wechselwirkungen, da sie durch Objekte verursacht wird, die die Raumzeit um sich herum krümmen, und nicht durch den Austausch von Teilchen. Die Verbindung der Quantenphysik mit der allgemeinen Relativitätstheorie hat sich als eine der größten Herausforderungen der Physik und unseres Verständnisses des Universums erwiesen [28,29]. Trotz vieler wissenschaftlicher Hürden, die noch zu nehmen sind, haben wir einige Erkenntnisse darüber gewonnen, wie das Universum funktioniert. Wenn wir die Quantenphysik als die “Maschinensprache des Universums” betrachten, können die universellen Wechselwirkungen als Programmiersprachen auf höherer Ebene interpretiert werden. Die Quantenphysik umfasst alle Phänomene und Effekte, die auf der Beobachtung beruhen, dass bestimmte Variablen nicht jeden beliebigen Wert annehmen können, sondern nur feste, diskrete Werte. Dazu gehören auch der Welle-Teilchen-Dualismus, die Nicht-Determiniertheit physikalischer Prozesse und deren unvermeidliche Beeinflussung durch Beobachtung. Die Quantenphysik umfasst alle Beobachtungen, Theorien, Modelle und Konzepte, die auf die Quantenhypothese von Max Planck zurückgehen, die um 1900 notwendig wurde, weil die klassische Physik an ihre Grenzen stieß, z. B. bei der Beschreibung des Lichts oder der Struktur der Materie. Die Unterschiede zwischen der Quantenphysik und der klassischen Physik zeigen sich besonders deutlich auf der mikroskopischen Skala, z. B. in der Struktur von Atomen und Molekülen, oder in besonders reinen Systemen wie der Supraleitung und der Laserstrahlung. Auch die chemischen oder physikalischen Eigenschaften verschiedener Stoffe, wie Farbe, Ferromagnetismus, elektrische Leitfähigkeit usw., lassen sich nur mit Hilfe der Quantenphysik verstehen. Die theoretische Quantenphysik umfasst die Quantenmechanik, die das Verhalten von Quantenobjekten unter dem Einfluss von Feldern beschreibt, und die Quantenfeldtheorie, die die Felder als Quantenobjekte behandelt. Die Vorhersagen beider Theorien stimmen sehr gut mit den experimentellen Ergebnissen überein, und das makroskopische Verhalten lässt sich von der kleinsten Skala ableiten. Wenn wir die Realität als das definieren, was wir um uns herum wahrnehmen, feststellen und messen können, dann ist die Quantenphysik das Gewebe der Realität. Daher muss eine genaue Simulation des Universums oder von Teilen davon auf der Quantenphysik beruhen. Die internen Zustände eines Computers, der für die Simulation verwendet wird, müssen in der Lage sein, alle externen Zustände genau zu repräsentieren, was einen Computer erfordert, der Quanteneffekte für die Berechnung nutzt und das Verhalten aller Quantenobjekte, einschließlich ihrer Wechselwirkungen, genau nachahmen kann. Die Anforderungen an einen solchen Computer gehen über die heute gebauten und für die Zukunft angedachten Quantencomputer hinaus. Die Entwicklung eines solchen Computers ist eine gewaltige Herausforderung, die in den folgenden Kapiteln erörtert wird.

Eines der Argumente, die später in diesem Artikel angeführt werden, ist die physikalische Vorhersagbarkeitsbeschränkung, die uns daran hindert, einen Computer zu bauen, mit dem sich alle zukünftigen Zustände des Universums durch Simulation vorhersagen lassen. Wäre die Natur rein klassisch, würde ein Computer nicht unter dieser Einschränkung leiden (es gibt allerdings noch andere), aber die Quantenphysik erlegt uns einige Beschränkungen auf, egal wie fortgeschritten unsere Theorien über die Funktionsweise der Natur sind. Im Rahmen der klassischen Mechanik kann die Flugbahn eines Teilchens ausschließlich aus seinem Ort und seiner Geschwindigkeit berechnet werden, wenn die wirkenden Kräfte bekannt sind. Der Zustand des Teilchens kann also eindeutig durch zwei Größen beschrieben werden, die bei idealen Messungen mit eindeutigen Ergebnissen gemessen werden können. Eine getrennte Behandlung des Zustands und der Messgrößen oder Observablen ist daher für die klassische Mechanik nicht notwendig, da der Zustand die Messwerte bestimmt und umgekehrt. Die Natur zeigt jedoch Quantenphänomene, die mit diesen Begriffen nicht beschrieben werden können. Auf der Quantenskala ist es nicht mehr möglich, vorherzusagen, wo und mit welcher Geschwindigkeit ein Teilchen nachgewiesen wird. Wird z. B. ein Streuexperiment mit einem Teilchen unter genau denselben Anfangsbedingungen wiederholt, so muss für das Teilchen nach dem Streuvorgang immer derselbe Zustand angenommen werden, obwohl es an unterschiedlichen Stellen auf dem Schirm auftreffen kann. Der Zustand des Teilchens nach dem Streuprozess bestimmt nicht seine Flugrichtung. Generell gibt es in der Quantenmechanik Zustände, die keine Vorhersage eines einzelnen Messergebnisses zulassen, selbst wenn der Zustand genau bekannt ist. Den potenziell gemessenen Werten können nur Wahrscheinlichkeiten zugeordnet werden. Daher werden in der Quantenmechanik Mengen und Zustände getrennt behandelt, und es werden andere Begriffe für diese Mengen verwendet als in der klassischen Mechanik.

In der Quantenmechanik werden alle messbaren Eigenschaften eines physikalischen Systems mathematischen Objekten, den sogenannten Observablen, zugeordnet. Beispiele sind der Ort eines Teilchens, sein Impuls, sein Drehimpuls oder seine Energie. Für jede Observable gibt es eine Menge spezieller Zustände, in denen das Ergebnis einer Messung nicht streuen kann, sondern eindeutig festgelegt ist. Ein solcher Zustand wird als Eigenzustand der Observablen bezeichnet, und das zugehörige Messergebnis ist einer der Eigenwerte der Observablen. In allen anderen Zuständen, die keine Eigenzustände dieser Observablen sind, sind andere Messergebnisse möglich. Sicher ist jedoch, dass bei dieser Messung einer der Eigenwerte ermittelt wird und sich das System dann in dem entsprechenden Eigenzustand dieser Observablen befindet. Für die Bestimmung, welcher der Eigenwerte für die zweite Observable zu erwarten ist oder – äquivalent – in welchem Zustand sich das System nach dieser Messung befinden wird, kann nur eine Wahrscheinlichkeitsverteilung angegeben werden, die sich aus dem Anfangszustand ermitteln lässt. Im Allgemeinen haben verschiedene Observablen verschiedene Eigenzustände. Für ein System, das den Eigenzustand einer Observablen als Anfangszustand annimmt, ist das Messergebnis einer zweiten Observablen unbestimmt. Der Anfangszustand wird als eine Überlagerung aller möglichen Eigenzustände der zweiten Observablen interpretiert. Der Anteil eines bestimmten Eigenzustands wird als seine Wahrscheinlichkeitsamplitude bezeichnet. Das Quadrat des Absolutwerts einer Wahrscheinlichkeitsamplitude gibt die Wahrscheinlichkeit an, den entsprechenden Eigenwert der zweiten Observablen bei einer Messung im Ausgangszustand zu erhalten. Im Allgemeinen kann jeder quantenmechanische Zustand als Überlagerung verschiedener Eigenzustände einer Beobachtungsgröße dargestellt werden. Die verschiedenen Zustände unterscheiden sich nur darin, welche dieser Eigenzustände zur Überlagerung beitragen und in welchem Ausmaß.

Für einige Observablen, wie z. B. den Drehimpuls, sind nur diskrete Eigenwerte zulässig. Im Falle des Teilchenortes hingegen bilden die Eigenwerte ein Kontinuum. Die Wahrscheinlichkeitsamplitude für das Auffinden des Teilchens an einem bestimmten Ort ist daher in Form einer ortsabhängigen Funktion, der sogenannten Wellenfunktion, gegeben. Das Quadrat des Absolutwertes der Wellenfunktion an einem bestimmten Ort gibt die räumliche Dichte der Wahrscheinlichkeit an, das Teilchen dort zu finden.

Nicht alle quantenmechanischen Observablen haben ein klassisches Gegenstück. Ein Beispiel ist der Spin, der sich nicht auf Eigenschaften zurückführen lässt, die aus der klassischen Physik bekannt sind, wie Ladung, Masse, Ort oder Impuls. Die Beschreibung der zeitlichen Entwicklung eines isolierten Systems erfolgt in der Quantenmechanik analog zur klassischen Mechanik mit Hilfe einer Bewegungsgleichung, der Schrödingergleichung. Durch L¨ osen dieser Differentialgleichung kann man berechnen, wie sich die Wellenfunktion des Systems entwickelt (siehe Gl. 1).

iℏ∂tψ=H (1)

In Gl. 1 beschreibt der Hamilton-Operator H die Energie des quantenmechanischen Systems. Der Hamilton-Operator besteht aus einem Term für die kinetische Energie der Teilchen im System und einem zweiten Term, der die Wechselwirkungen zwischen ihnen im Falle mehrerer Teilchen und die potentielle Energie im Falle externer Felder beschreibt, wobei die externen Felder auch zeitabhängig sein können. Im Gegensatz zur Newtonschen Mechanik werden die Wechselwirkungen zwischen verschiedenen Teilchen nicht als Kräfte, sondern als Energieterme beschrieben, ähnlich der Methodik der klassischen Hamiltonschen Mechanik. Dabei ist die elektromagnetische Wechselwirkung in den typischen Anwendungen auf Atome, Moleküle und Festkörper besonders relevant.

Die Schrödinger-Gleichung ist eine partielle Differentialgleichung erster Ordnung in der Zeitkoordinate, so dass die zeitliche Entwicklung des quantenmechanischen Zustands eines geschlossenen Systems vollständig deterministisch ist. Wenn der Hamilton-Operator H eines Systems selbst nicht von der Zeit abhängt, hat dieses System stationäre Zustände, d. h. Zustände, die sich mit der Zeit nicht ändern. Das sind die Eigenzustände des Hamilton-Operators H. Nur in ihnen hat das System eine wohldefinierte Energie E, zum Beispiel den jeweiligen Eigenwert (siehe Gl. 2).

Hψ=Eψ (2)

Die Schrödinger-Gleichung reduziert sich dann auf Gl. 3

iℏ∂tψ=Eψ (3)

Die Quantenmechanik beschreibt auch, wie genau wir messen und somit Vorhersagen machen können. Niels Bohr beklagte sich bekanntlich, dass Vorhersagen schwer sind, insbesondere über die Zukunft. Die Unschärferelation der Quantenmechanik, die als Heisenbergsche Unschärferelation bekannt ist, setzt die kleinstmöglichen theoretisch erreichbaren Unsicherheitsbereiche zweier Messgrößen in Beziehung. Sie gilt für jedes Paar komplementärer Messgrößen, insbesondere für Paare von Messgrößen, die wie Ort und Impuls oder Drehwinkel und Drehimpuls physikalische Messgrößen beschreiben, die in der klassischen Mechanik kanonisch konjugiert genannt werden und kontinuierliche Werte annehmen können.

Wenn eine dieser Größen für das betrachtete System einen exakt bestimmten Wert hat, dann ist der Wert der anderen völlig unbestimmt. Dieser Extremfall ist jedoch nur von theoretischem Interesse, da keine reale Messung völlig exakt sein kann. Tatsächlich ist der Endzustand der Messung der Observablen A also kein reiner Eigenzustand der Observablen A, sondern eine Überlagerung mehrerer dieser Zustände zu einem bestimmten Bereich von Eigenwerten zu A. Bezeichnet man mit ∆A den Unsicherheitsbereich von A, mathematisch definiert durch die sogenannte Standardabweichung, so gilt für den Unsicherheitsbereich ∆B der kanonisch konjugierten Observablen B die Ungleichung in Gl. 4.

A∙B≥h4π=2 (4)

Ein weiteres quantenphysikalisches Phänomen ist die Verschränkung: Ein zusammengesetztes physikalisches System, zum Beispiel ein System mit mehreren Teilchen, nimmt als Ganzes betrachtet einen wohldefinierten Zustand an, ohne dass jedem Teilsystem ein wohldefinierter Zustand zugeordnet werden kann. Dieses Phänomen gibt es in der klassischen Physik nicht. Dort sind zusammengesetzte Systeme immer trennbar. Das heißt, jedes Teilsystem hat zu jedem Zeitpunkt einen bestimmten Zustand, der sein individuelles Verhalten bestimmt, wobei die Gesamtheit der Zustände der einzelnen Teilsysteme und deren Wechselwirkung das Verhalten des Gesamtsystems vollständig erklären. In einem quantenphysikalisch verschränkten Zustand des Systems hingegen haben die Teilsysteme mehrere ihrer möglichen Zustände nebeneinander, wobei jedem dieser Zustände eines Teilsystems ein anderer Zustand der anderen Teilsysteme zugeordnet ist. Um das Verhalten des Gesamtsystems richtig zu erklären, muss man alle diese nebeneinander existierenden Möglichkeiten zusammen betrachten. Dennoch zeigt eine Messung an jedem Teilsystem immer nur eine dieser Möglichkeiten an, wobei die Wahrscheinlichkeit, dass dieses bestimmte Ergebnis eintritt, durch eine Wahrscheinlichkeitsverteilung bestimmt wird. Messergebnisse mehrerer verschränkter Teilsysteme sind miteinander korreliert, d.h. je nach Messergebnis eines Teilsystems ergibt sich eine andere Wahrscheinlichkeitsverteilung für die möglichen Messergebnisse der anderen Teilsysteme.

Es gäbe noch viel mehr über die Quantenphysik zu sagen und darüber, wie sie sich von der alltäglichen makroskopischen Welt, die wir wahrnehmen, unterscheidet, aber es genügt zu sagen, dass sowohl die Verschränkung als auch die Überlagerung bereits die Komplexität einer Simulation selbst kleiner Systeme massiv erhöhen. Um genaue Quantensimulationen durchführen zu können, ist ein Quantencomputer erforderlich, der im nächsten Kapitel vorgestellt wird.

IV. QUANTENTECHNOLOGIEN

Um die Natur akkurat – quantenphysikalisch – zu simulieren, werden klassische Computer überfordert sein, egal wie leistungsfähig sie in ferner Zukunft werden [30-32]. Die der Quantenskala innewohnende Komplexität, einschließlich des exponentiellen Anstiegs der Berechnungskomplexität mit jeder zusätzlichen Wechselwirkung, kann nur mit einer speziellen Quantentechnologie – einem Quantencomputer – bewältigt werden. Mit dem Aufkommen von Quantentechnologien, die auf den grundlegendsten physikalischen Gesetzen des Universums aufbauen, scheint die Frage, ob das Universum, das wir bewohnen, und alles darin simuliert werden kann, möglicherweise auf einem Quantencomputer, nicht mehr so obskur zu sein. Die erste Quantenrevolution, die durch die bahnbrechenden Forschungen und Entdeckungen der großen Physiker des frühen 20. Jahrhunderts eingeleitet wurde, hat viele der exponentiellen technologischen Entwicklungen der letzten Jahrzehnte nicht nur befruchtet, sondern erst möglich gemacht [33,34]. Die Entwicklung von Lasern hat uns unter anderem die Glasfaserkommunikation, Laserdrucker, optische Speichermedien, die Laserchirurgie und die Photolithographie in der Halbleiterfertigung beschert. Atomuhren ermöglichten das Global Positioning System (GPS), das u. a. zur Navigation und Kartierung eingesetzt wird, und Transistoren machten moderne Computer möglich. Diese und andere Technologien der ersten Quantenrevolution sind für die Menschheit und die Wirtschaft von entscheidender Bedeutung. Ein Großteil der Technologie, die wir in unserem Alltag als selbstverständlich ansehen, kam während der ersten Quantenrevolution ans Licht. Die erste Quantenrevolution zeichnete sich durch die Entwicklung von Technologien aus, die sich Quanteneffekte zunutze machen; inzwischen haben wir jedoch erkannt, dass diese Technologien das Potenzial der Quantenphysik nicht voll ausschöpfen. Angetrieben von den immensen Fortschritten bei der Erkennung und Manipulation einzelner Quantenobjekte werden nun große Fortschritte bei der Entwicklung und Kommerzialisierung von Anwendungen in der Quantentechnologie gemacht, wie z. B. Quantencomputer, -kommunikation und -sensoren, die als zweite Quantenrevolution gelten, bei der die grundlegenden Eigenschaften der Quantenphysik weiterhin genutzt werden. Teilchen können nicht nur in zwei Zuständen gleichzeitig sein, wie es bei den Atomen in einer Atomuhr der Fall ist. Unter bestimmten Bedingungen spüren zwei weit voneinander entfernte Teilchen etwas über den Zustand des anderen – sie beeinflussen sich gegenseitig, was als Verschränkung bezeichnet wird und schon Albert Einstein suspekt war. Die genaue Position oder der Zustand eines Teilchens ist nicht bekannt, solange keine Messung durchgeführt wird. Stattdessen zeigt uns die Natur, dass es nur Wahrscheinlichkeiten für ein bestimmtes Ergebnis gibt, und eine Messung – ein Blick – verändert die Situation unwiderruflich. Im Vergleich dazu ging es bei der ersten Quantenrevolution darum zu verstehen, wie die Welt in den winzigen Maßstäben funktioniert, in denen die Quantenmechanik vorherrscht. Bei der zweiten geht es um die Kontrolle einzelner Quantensysteme, z. B. einzelner Atome [33,35]. Darauf aufbauende quantenmechanische Vorhersagen werden genutzt, um bisher unerreichte Präzision zu messen. Es ist auch möglich, unknackbare Codes zu erzeugen, die von keinem System entschlüsselt werden können und damit die Grundlage für ein sicheres Kommunikationsnetz bilden [36-38]. Darüber hinaus versprechen Quantencomputer die Lösung einiger bisher unlösbarer Probleme, darunter die Simulation von Molekülen und ihren Wechselwirkungen zur Entwicklung von Medikamenten gegen bisher unheilbare Krankheiten oder zur Suche nach neuen Materialien [39,40]. Hybride Computersysteme, die klassische Hochleistungsrechner mit Quantencomputern kombinieren, werden bereits heute eingesetzt, um Lösungen in den Bereichen Mobilität, Finanzen, Energie, Luft- und Raumfahrt und vielen anderen Bereichen zu entwickeln [41-47]. All diese Entwicklungen finden gerade jetzt statt, und es ist bemerkenswert, dass viele Herausforderungen nicht mehr rein wissenschaftlicher, sondern technischer Natur sind. So wird beispielsweise an der Miniaturisierung von Atomuhren und der Robustheit von Quantenbits, den Informationseinheiten eines Quantencomputers, gearbeitet. Darüber hinaus gibt es bereits Ansätze zur Verstärkung und Weiterleitung von Quantenkommunikationssignalen, um die internetbasierte Kommunikation sicherer als je zuvor zu machen [36-38].

Der Quantencomputer, in den große Hoffnungen für die quantenphysikalische Simulation von Physik und Chemie gesetzt werden, ist die Quantentechnologie, die bei den Überlegungen zur Simulation des Universums eingehender diskutiert und analysiert werden sollte. Es ist viel darüber diskutiert worden, ob ein ausreichend leistungsfähiger und fehlerbereinigter Quantencomputer dazu verwendet werden kann, das Universum oder Teile davon zu simulieren. Wenn wir mit “dem Universum” das Universum meinen, in dem wir leben, dann ist dies selbst mit Quantencomputern, die Milliarden von qualitativ hochwertigen Quantenbits verwenden, nicht möglich – sowohl physikalische als auch rechnerische Beschränkungen, die in den folgenden Kapiteln erörtert werden, verhindern dies. Ein Quantenprozessor oder Quantencomputer ist ein Prozessor, der die Gesetze der Quantenmechanik nutzt. Im Gegensatz zum klassischen Computer arbeitet er nicht auf der Grundlage elektrischer, sondern quantenmechanischer Zustände. Das Superpositionsprinzip – die quantenmechanische Kohärenz – ist beispielsweise analog zu den Kohärenzeffekten und zweitens die Quantenverschränkung, die der klassischen Korrelation entspricht, wenn auch stärker als die klassische.

Studien und praktische Umsetzungen zeigen bereits, dass mit diesen Effekten bestimmte Informatikprobleme wie die Suche in großen Datenbanken oder die Faktorisierung großer Zahlen effizienter gelöst werden können als mit klassischen Computern. Darüber hinaus könnte mit Quantencomputern die Rechenzeit für viele mathematische und physikalische Probleme erheblich reduziert werden. Bevor wir die Simulation von Teilen des Universums mit Hilfe eines Quantencomputers und bestimmte Einschränkungen diskutieren, ist es wichtig, die Unterschiede zwischen der Informationsverarbeitung in klassischen und Quantencomputern zu verstehen. In einem klassischen Computer werden alle Informationen in Bits dargestellt. Ein Bit wird physikalisch durch einen Transistor realisiert, in dem ein elektrisches Potential entweder über oder unter einer bestimmten Schwelle liegt.

Auch in einem Quantencomputer wird die Information in der Regel in binärer Form dargestellt. Hier verwendet man ein physikalisches System mit zwei orthogonalen Grundzuständen eines komplexen zweidimensionalen Raumes, wie es in der Quantenmechanik vorkommt. In der Dirac-Notation wird der eine Grundzustand durch den quantenmechanischen Zustandsvektor |0⟩, der andere durch den Zustandsvektor |1⟩ dargestellt. Diese quantenmechanischen Zwei-Niveau-Systeme können z. B. der Spinvektor eines Elektrons sein, der entweder nach oben oder nach unten zeigt. Andere Implementierungen verwenden das Energieniveau in Atomen oder Molekülen oder die Richtung des Stromflusses in einem toroidalen Supraleiter. Oft werden nur zwei Zustände aus einem größeren Hilbert-Raum des physikalischen Systems ausgewählt, z. B. die beiden niedrigsten Energieeigenzustände eines gefangenen Ions. Ein solches quantenmechanisches System mit zwei Zuständen wird als Quantenbit bezeichnet, kurz: Qubit. Eine Eigenschaft von quantenmechanischen Zustandsvektoren ist, dass sie eine Überlagerung anderer Zustände sein können. Ein Qubit muss nicht entweder |0⟩ oder |1⟩ sein, wie dies bei den Bits des klassischen Computers der Fall ist. Stattdessen ist der Zustand eines Qubits in dem oben erwähnten komplexen zweidimensionalen Raum durch |0⟩:=1 0 ; |1⟩:=0 1 gegeben. Eine Überlagerung |ψ⟩ ist dann allgemein eine komplexe Linearkombination dieser orthonormalen Basisvektoren (Gl. 5), mit c0,c1 C.

|⟩=c0|0⟩+c1|1⟩=c0 c1 (5)

c02 + c12 = 1 (6)

Wie in der kohärenten Optik sind beliebige Überlagerungszustände erlaubt. Der Unterschied zwischen klassischem und quantenmechanischem Rechnen ist analog zu dem zwischen inkohärenter und kohärenter Optik. Im ersten Fall werden die Intensitäten addiert, im zweiten Fall werden die Feldamplituden direkt addiert, wie in der Holographie. Zur Normalisierung summieren sich die quadrierten Amplituden zu Eins (Gl. 6), und ohne Verlust der Allgemeingültigkeit kann c sub 0 reell und nicht-negativ sein. Das Qubit wird in der Regel durch Messung einer Beobachtungsgröße ausgelesen, die diagonal und nicht entartet in ihrer Basis {|0⟩,|1⟩} ist, z. B. A=|1⟩⟨1|. Die Wahrscheinlichkeit, als Ergebnis dieser Messung im Zustand |ψ⟩ den Wert 0 zu erhalten, ist P(0)=⟨⟩2=c02 und die des Ergebnisses 1 entsprechend P(1)=⟨⟩2=1- P(0) = c12. Dieses probabilistische Verhalten darf nicht so interpretiert werden, dass sich das Qubit mit einer bestimmten Wahrscheinlichkeit im Zustand 0 und mit einer anderen Wahrscheinlichkeit im Zustand 1 befindet, während andere Zustände nicht erlaubt sind. Ein solches Ausschließlichkeitsverhalten könnte auch mit einem klassischen Computer erreicht werden, der mit Hilfe eines Zufallsgenerators entscheidet, ob er beim Auftreten überlagerter Zustände mit 0 oder 1 weiterrechnet. In der statistischen Physik, die im Gegensatz zur Quantenmechanik inkohärent ist, wird ein solches Ausschließlichkeitsverhalten berücksichtigt; beim Quantencomputer ist jedoch die kohärente Überlagerung der verschiedenen Basiszustände, die relative Phase zwischen den verschiedenen Komponenten der Überlagerung und, im Verlauf der Berechnung, die Interferenz zwischen ihnen entscheidend. Wie beim klassischen Computer werden mehrere Qubits zu Quantenregistern zusammengefasst. Nach den Gesetzen der Vielteilchen-Quantenmechanik ist der Zustand eines Qubit-Registers dann ein Zustand aus einem 2N-dimensionalen Hilbert-Raum, dem Tensorprodukt der Zustandsräume der einzelnen Qubits. Eine mögliche Basis dieses Vektorraums ist die Produktbasis über der Basis 0 und 1. Für ein Register aus zwei Qubits würde man die Basis 00 erhalten. Der Zustand des Registers kann folglich eine beliebige Superposition dieser Basiszustände sein, d.h. er hat die Form von Gl. 7.

|⟩=i1,…,iNci1iN|i1i2iN⟩ (7)

ci1iN sind beliebige komplexe Zahlen, und i1i2iN∈0,1, während in klassischen Computern nur die Basiszustände auftreten. Die Zustände eines Quantenregisters lassen sich nicht immer aus den Zuständen unabhängiger Qubits zusammensetzen; Gl. 8 zeigt einen solchen Beispielzustand.

|⟩=12|01⟩+|10⟩ (8)

Der Zustand in Gl. 8 und andere können nicht in ein Produkt aus einem Zustand für das erste Qubit und einem Zustand für das zweite Qubit zerlegt werden. Ein solcher Zustand wird daher auch als verschränkt bezeichnet. Die Verschränkung ist ein Grund dafür, dass Quantencomputer effizienter sein können als klassische Computer. Quantencomputer können bestimmte Probleme exponentiell schneller lösen als klassische Computer: Um den Zustand eines klassischen N-Bit-Registers darzustellen, werden N Bits an Informationen benötigt. Der Zustand des Quantenregisters ist jedoch ein Vektor aus einem 2N-dimensionalen Vektorraum, so dass 2N komplexwertige Koeffizienten für seine Darstellung erforderlich sind. Wenn N groß ist, ist die Zahl 2N viel größer als N selbst. Das Prinzip der Superposition wird oft so erklärt, dass ein Quantencomputer alle 2N Zahlen von 0 bis 2N – 1 gleichzeitig in einem Quantenregister von N Qubits speichern könnte, aber diese Vorstellung ist irreführend. Da eine Messung am Register immer genau einen der Basiszustände auswählt, kann mit dem Holevo-Theorem gezeigt werden, dass der maximal zugängliche Informationsgehalt eines N-Qubit-Registers genau N Bits beträgt, genau wie der eines klassischen N-Bit-Registers. Es ist jedoch richtig, dass das Superpositionsprinzip eine Parallelität der Berechnungen ermöglicht, die über die eines klassischen Parallelrechners hinausgeht. Der Hauptunterschied zum klassischen Parallelrechner besteht darin, dass die durch das Überlagerungsprinzip ermöglichte Quantenparallelität nur durch Interferenz genutzt werden kann. Bei einigen Problemen kann mit Quantenalgorithmen eine stark reduzierte Laufzeit im Vergleich zu klassischen Methoden erreicht werden. Bei komplexen Rechenaufgaben – und die Simulation des Universums ist zweifellos sehr rechenintensiv und komplex – ist es eine interessante Frage, was mit einem Quantencomputer und klassischen Computern berechnet werden kann. Da die Funktionsweise eines Quantencomputers formal definiert ist, lassen sich die aus der theoretischen Informatik bekannten Begriffe, wie Berechenbarkeit oder Komplexitätsklasse, auch auf einen Quantencomputer übertragen. Es zeigt sich, dass die Zahl der berechenbaren Probleme für einen Quantencomputer nicht größer ist als für einen klassischen Computer. Das heißt, die Church-Turing-These gilt auch für Quantencomputer. Es gibt jedoch starke Hinweise darauf, dass einige Probleme mit einem Quantencomputer exponentiell schneller gelöst werden können. Der Quantencomputer stellt somit ein mögliches Gegenbeispiel zur erweiterten Church-Turing-These dar. Ein klassischer Computer kann einen Quantencomputer simulieren, da die Aktion der Gatter auf dem Quantenregister einer Matrix-Vektor-Multiplikation entspricht. Der klassische Computer muss nun lediglich all diese Multiplikationen durchführen, um den Anfangszustand in den Endzustand des Registers zu überführen. Die Folge dieser Simulationsfähigkeit ist, dass alle Probleme, die auf einem Quantencomputer gelöst werden können, auch auf einem klassischen Computer gelöst werden können; allerdings kann ein klassischer Computer dafür Tausende von Jahren benötigen, während ein Quantencomputer nur Sekunden braucht. Im Umkehrschluss bedeutet dies, dass Probleme wie das Halteproblem auch auf Quantencomputern nicht gelöst werden können und impliziert, dass auch ein Quantencomputer kein Gegenbeispiel zur Church-Turing-These darstellt. Im Rahmen der Komplexitätstheorie werden algorithmische Probleme in so genannte Komplexitätsklassen eingeordnet. Die bekanntesten und wichtigsten Vertreter sind die Klassen P und NP. Dabei bezeichnet P diejenigen Probleme, deren Lösung deterministisch in einer polynomialen Laufzeit zur Eingabelänge berechnet werden kann. Die Probleme, für die es Lösungsalgorithmen gibt, die nichtdeterministisch polynomiell sind, liegen in NP. Für Quantencomputer wurde die Komplexitätsklasse BQP definiert, die diejenigen Probleme enthält, deren Laufzeit polynomiell von der Eingabelänge abhängt und deren Fehlerwahrscheinlichkeit kleiner als 13 ist. Der Nichtdeterminismus erlaubt es, verschiedene Möglichkeiten gleichzeitig zu testen. Da die heutigen klassischen Computer deterministisch arbeiten, muss der Nichtdeterminismus simuliert werden, indem die verschiedenen Möglichkeiten nacheinander ausgeführt werden, was zu einem Verlust der Polynomialität der Lösungsstrategie führen kann. Mit diesen Ergebnissen und Definitionen im Hinterkopf ist es nun an der Zeit, die mögliche Machbarkeit der Simulation des Universums oder von Teilen davon zu diskutieren.

V. DAS SCHICKSAL DES UNIVERSUMS

A. Der Beginn des Universums

Eine Simulation des Universums oder von Teilen davon erfordert eine genaue Simulation seiner Entwicklung von Anfang an. In der Kosmologie gilt der Urknall, der auf die kosmische Inflation folgte, als Ausgangspunkt für die Entstehung von Materie, Raum und Zeit. Nach dem kosmologischen Standardmodell fand der Urknall vor etwa 13,8 × 109 Jahren statt. Der Begriff “Urknall” bezieht sich nicht auf eine Explosion in einem bestehenden Raum, sondern auf die gemeinsame Entstehung von Materie, Raum und Zeit aus einer Ursingularität. Dies ergibt sich formal, wenn man die Entwicklung des expandierenden Universums bis zu dem Punkt zurückverfolgt, an dem die Materie- und Energiedichte unendlich wird. Demnach müsste die Dichte des Universums kurz nach dem Urknall die Planck-Dichte überschritten haben. Die allgemeine Relativitätstheorie reicht nicht aus, um diesen Zustand zu beschreiben; es wird jedoch erwartet, dass eine noch zu entwickelnde Theorie der Quantengravitation dies tun wird. Daher gibt es in der heutigen Physik keine allgemein anerkannte Beschreibung des sehr frühen Universums, des Urknalls selbst oder der Zeit vor dem Urknall. Die Urknalltheorien beschreiben nicht den Urknall selbst, sondern die zeitliche Entwicklung des frühen Universums nach dem Urknall, von der Planck-Zeit (etwa 10-43 Sekunden) nach dem Urknall bis etwa 300.000 bis 400.000 Jahre später, als sich stabile Atome zu bilden begannen und das Universum transparent wurde. Die weitere Entwicklung des Universums wird nicht als der Bereich des Urknalls betrachtet. Die Urknalltheorien beruhen auf zwei Grundannahmen:

- Die Naturgesetze sind universell, so dass wir das Universum mit den Naturgesetzen beschreiben können, die heute in der Nähe der Erde gelten. Um das gesamte Universum in jedem seiner Entwicklungsstadien auf der Grundlage der uns bekannten Naturgesetze beschreiben zu können, muss man davon ausgehen, dass diese Naturgesetze universell und konstant gelten, unabhängig von der Zeit. Keine Beobachtung der Astronomie, die etwa 13,5×109 Jahre zurückreicht – oder der Paläogeologie, die 4×109 Jahre zurückreicht – stellt diese Annahme in Frage. Aus der angenommenen Konstanz und Universalität der heute bekannten Naturgesetze folgt, dass wir die Entwicklung des Universums als Ganzes mit der allgemeinen Relativitätstheorie und die dort ablaufenden Prozesse mit dem Standardmodell der Elementarteilchenphysik beschreiben können. Im Extremfall hoher Materiedichte und gleichzeitig hoher Raumzeitkrümmung sind die allgemeine Relativitätstheorie und die Quantenfeldtheorien, auf denen das Standardmodell beruht, zur Beschreibung erforderlich. Die Vereinheitlichung stößt jedoch auf grundlegende Schwierigkeiten, so dass die ersten Mikrosekunden der Geschichte des Universums derzeit nicht konsistent beschrieben werden können.

- Das Universum sieht an jedem Ort (aber nicht zu jedem Zeitpunkt) in allen Richtungen über große Entfernungen gleich aus. Die Annahme der räumlichen Homogenität wird als kopernikanisches Prinzip bezeichnet und wird durch die Annahme der Isotropie zum kosmologischen Prinzip erweitert. Das kosmologische Prinzip besagt, dass das Universum an jedem Punkt des Raums und in allen Richtungen für große Entfernungen gleichzeitig gleich aussieht, was als räumliche Homogenität bezeichnet wird. Die Annahme, dass es in allen Richtungen gleich aussieht, wird als räumliche Isotropie bezeichnet. Ein Blick auf den Sternenhimmel mit bloßem Auge zeigt, dass das Universum in der Nähe der Erde nicht homogen und isotrop ist, weil die Verteilung der Sterne unregelmäßig ist. In einem größeren Maßstab bilden die Sterne Galaxien, die teilweise Galaxienhaufen bilden, die in einer wabenartigen Struktur aus Fäden und Hohlräumen verteilt sind. In noch größerem Maßstab ist jedoch keine Struktur zu erkennen. Dies und der hohe Grad der Isotropie der kosmischen Hintergrundstrahlung rechtfertigen die Beschreibung des Universums als Ganzes durch das kosmologische Prinzip. Wendet man das kosmologische Prinzip auf die allgemeine Relativitätstheorie an, so vereinfachen sich die Einsteinschen Feldgleichungen zu den Friedmann-Gleichungen, die ein homogenes, isotropes Universum beschreiben. Um die Gleichungen zu lösen, beginnt man mit dem aktuellen Zustand des Universums und verfolgt die Entwicklung in der Zeit zurück. Die genaue Lösung hängt insbesondere von den gemessenen Werten der Hubble-Konstante und verschiedener Dichteparameter ab, die den Massen- und Energiegehalt des Universums beschreiben. So stellt man fest, dass das Universum früher kleiner war. Gleichzeitig war es aber auch heißer und dichter. Formal führt die Lösung zu einem Zeitpunkt, an dem der Wert des Skalenfaktors verschwindet, d. h. das Universum keine Ausdehnung mehr hat und die Temperatur und Dichte unendlich groß werden. Dieser Zeitpunkt wird als “Urknall” bezeichnet. Er ist eine formale Singularität der Lösung der Friedmann-Gleichungen. Dies sagt jedoch nichts über die physikalische Realität einer solchen Anfangssingularität aus, denn die Gleichungen der klassischen Physik haben nur einen begrenzten Gültigkeitsbereich und sind nicht mehr anwendbar, wenn Quanteneffekte eine Rolle spielen, wie es im sehr frühen, heißen und dichten Universum angenommen wird. Eine Theorie der Quantengravitation ist erforderlich, um die Entwicklung des Universums in sehr frühen Zeiten zu beschreiben.

B. Die Zukunft des Universums

Die hellsten Sterne bestimmen die Helligkeit von Galaxien. In unserer Galaxie gibt es 100 Milliarden Sterne, von denen 90 Prozent kleiner als die Sonne sind, und 9 Prozent davon sind etwa so groß wie unsere Sonne und bis zu 2,5 Mal massereicher. Nur ein Prozent ist viel größer als die Sonne. Dieses eine Prozent der Sterne bestimmt jedoch die Helligkeit der Galaxie. Je größer ein Stern ist, desto verschwenderischer geht er mit seinem Kernbrennstoff um. Die hellsten Sterne leben nur einige zehn Millionen Jahre und explodieren am Ende ihres Lebens. Dabei reichern sie das interstellare Gas mit schweren Elementen an. Außerdem verdichten die Schockwellen der Explosion das Gas, so dass neue Sterne entstehen können. Durch diesen verschwenderischen Umgang mit Kernbrennstoff ist jedoch irgendwann kein Gas mehr für die Entstehung neuer Sterne vorhanden. Unsere Sonne enthält bereits 2 Prozent schwere Elemente, wobei der Anteil weiter zunimmt, so dass in einem Zeitraum von höchstens tausend Milliarden Jahren kein Gas mehr für die Bildung neuer Sterne zur Verfügung stehen wird. Unsere Galaxie wird dann schwach durch die kleineren Sterne leuchten, die viel länger leben als die Sonne. Die kleinsten von ihnen werden erst nach 1012-1013 Jahren erlöschen. Diese leuchten aber bereits so schwach, dass für unsere Augen – wenn es noch Menschen in ihrer jetzigen Form gibt – der Himmel fast sternenlos aussehen würde, da wir nur noch solche schwachen Sterne in der Nähe erkennen würden. In etwa 1013 Jahren wird das Universum langsam dunkel werden. Das Universum besteht dann nur noch aus langsam sterbenden Weißen Zwergen, Planeten, Pulsaren – den 20-Kilometer-Kernen von Riesensternen mit einer Dichte wie in einem Atomkern – und Schwarzen Löchern. Auch wenn es dunkel ist, sind die Gravitationskräfte der Sterne noch vorhanden. Sterne sind normalerweise weit voneinander entfernt. Die Erde ist acht Lichtminuten von der Sonne entfernt, und der nächste Stern ist 4,3 Lichtjahre entfernt. Eine sehr nahe Begegnung mit einem anderen Stern ist zwar unwahrscheinlich, reicht aber aus, um die Erde aus ihrer Umlaufbahn um die längst ausgebrannte Sonne zu werfen. In diesem Szenario wandert die Erde allein durch die Milchstraße. Dass ein Zusammentreffen mit einem massereichen Partner so nahe ist, dass es auch die Sonne betrifft, ist noch unwahrscheinlicher, aber selbst ein solches Ereignis sollte einmal in 1019 Jahren stattgefunden haben. Die Sonne fällt entweder näher an das galaktische Zentrum heran oder wird aus unserer Galaxie vertrieben. Sterne, die nicht aus unserer Galaxie verdrängt werden, fallen Sagittarius A* zum Opfer, dem Schwarzen Loch im Zentrum der Galaxie. Derzeit hat es eine Masse von 4,31±0,38106 Sonnenmassen, aber nach 1024 Jahren sind wahrscheinlich alle in dem System verbliebenen Sterne verschluckt worden. Nach dem heutigen Modell der Entstehung des Universums gehen wir davon aus, dass es aus einem Punkt, einer Singularität aller Masse, entstanden ist und sich seitdem weiter ausdehnt. Ob dies auch weiterhin der Fall sein wird, hängt davon ab, wie viel Materie sich im Universum befindet. Die Materie verlangsamt die Ausdehnung durch die Anziehungskraft der Schwerkraft. Wenn genügend Materie im Universum vorhanden ist, kann die Expansion schließlich zum Stillstand kommen und sich dann umkehren, so dass das Universum in einer Singularität endet. Das Universum wird weiter expandieren, wenn die Materie für dieses Szenario nicht ausreicht. Die dafür erforderliche Menge an Materie wird als kritische Dichte bezeichnet. Die Materie, die wir beobachten können (Sterne, Gaswolken), reicht dafür nicht aus, aber wir vermuten, dass es noch Materie geben könnte, die wir nicht sehen können, die so genannte dunkle Materie. Dabei könnte es sich um Elementarteilchen, schwarze Löcher oder verhinderte Sterne handeln, deren Masse nicht ausreichte, um den Kernbrennstoff zu zünden. Es gibt Hinweise auf erhebliche Mengen an dunkler Materie, da die Masse in Galaxienhaufen nicht ausreicht, um sie zusammenzuhalten. Nach der Relativitätstheorie stehen Raum und Zeit in Wechselwirkung mit Materie und Energie. Die Gravitation der Materie im Universum verlangsamt die kosmische Expansion. In der fernen Vergangenheit hätte die Expansionsrate größer sein müssen. Wenn die mittlere Dichte der Materie im Universum über einem bestimmten “kritischen” Wert liegt, dann sollte die Expansion sogar irgendwann zum Stillstand kommen und in eine Kontraktion übergehen. Diese kritische Dichte liegt bei etwa zwei bis drei Wasserstoffatomen pro Kubikmeter, was in etwa der Masse eines Sandkorns, verteilt auf das Volumen der Erde, entspricht. Die Beobachtungen zeigen jedoch, dass die Gesamtmasse der sichtbaren Materie – Gas, Sterne und Staub – höchstens für ein Prozent der kritischen Dichte ausreicht. Nach unserem heutigen Verständnis besteht die Hauptmasse des Universums aus dunkler Materie. Dunkel, weil sie sich nur durch die Schwerkraft in den Bewegungen der Sterne und Galaxien bemerkbar macht, aber nicht beobachtbar ist. Allerdings beträgt die Dichte nur etwa 30 Prozent der kritischen Grenze. Dafür spricht nun die Erforschung der Galaxienhaufen: ihre räumliche Verteilung und Dynamik, ihre zeitliche Entwicklung aufgrund von Beobachtungen und theoretischen Modellen sowie das Ausmaß von Gravitationslinseneffekten – Lichtablenkung entfernter Galaxien durch Vordergrundobjekte. Die durchschnittliche Dichte des Universums reicht also nicht aus, um seine Expansion zu stoppen. Dennoch haben Theoretiker lange Zeit ein Universum mit kritischer Dichte favorisiert, weil dies die einfachste Lösung ist, die am besten zur Hypothese der kosmischen Inflation passt. Die Hypothese der kosmischen Inflation besagt, dass sich das Universum in den ersten Sekundenbruchteilen nach dem Urknall exponentiell ausdehnen sollte, als es noch kleiner als ein Atom war – um den Faktor 1030. Auch das Muster der winzigen Temperaturschwankungen in der kosmischen Hintergrundstrahlung spricht für ein solches Universum mit kritischer Dichte. Sie ist der Nachhall des Urknalls und enthält subtile Informationen über die gesamten Eigenschaften des Universums. Die Dichte Ωtot ist durch Gl. 9 gegeben.

Ωtot=c (9)

wobei die mittlere Dichte und c die kritische Dichte ist, die ihrerseits durch Gleichung 10 definiert ist.

c=3H028πG≈8.5∙10-27kgm3 (10)

wobei H0 der aktuelle Hubble-Parameter ist, der die Expansionsrate des Universums angibt, und G die Gravitationskonstante ist. Ob die Masse ausreicht, um die Expansion des Universums zu stoppen, ist heute unbekannt. Die beobachtbare Masse macht nur 10-20 Prozent der kritischen Dichte aus.

Kritische Dichte >1: In diesem Fall kehrt sich die Expansion des Universums um, und das Universum wird in ferner Zukunft kollabieren. Für einen Beobachter wäre die Umkehrung der Expansion zunächst nicht erkennbar. Erst wenn nur noch eine Milliarde Jahre bis zum Kollaps verbleiben, bemerken Beobachter, dass der Himmel wieder heller wird. Es werden immer mehr Galaxien am Himmel erscheinen, da die Abstände zwischen den Galaxien kleiner werden. Um diese Zeit werden auch die Galaxienhaufen verschmelzen. Etwa 100×106 Jahre vor dem Kollaps verschmelzen die Galaxien, und Sterne werden nur noch in einer Gaswolke zu finden sein. Eine Million Jahre vor dem Kollaps wird die Temperatur im Weltraum auf Raumtemperatur ansteigen. Hunderttausend Jahre vor dem Kollaps wird der Nachthimmel so hell sein wie die Oberfläche der Sonne. Die Temperatur im Universum wird so stark ansteigen, dass die Planeten zu flüssigen Klumpen werden. Je weiter die Materie zusammengedrückt wird, desto schneller wachsen die schwarzen Löcher. Außerdem können Neutronensterne und Zwergsterne durch die Aufnahme von Materie neue Schwarze Löcher bilden. Zehn Jahre vor dem Kollaps verschmelzen sogar die schwarzen Löcher. Die Temperatur im Universum beträgt nun 10×106 Grad. Schließlich ist das Universum nur ein schwarzes Loch, so dass es keine Rolle spielt, ob es kollabiert, denn in einem schwarzen Loch gibt es weder Zeit noch Raum mehr. Ansonsten läuft jetzt alles rückwärts, wie beim Urknall: Neue Energie bildet spontan neue Teilchen, die Grundkräfte der Natur trennen sich, und alles endet in einer großen Singularität.

Kritische Dichte =0: Der langweiligste Fall. Wenn die Materiedichte genau den kritischen Wert hat, geht die Expansionsrate in unendlicher Zeit immer mehr gegen Null. Die Bedingungen in diesem Universum ähneln denen in einem Universum mit einem Omega von weniger als 1. Allerdings werden sich ein Elektron und ein Positron in astronomischen Abständen umkreisen. Sie kommen sich immer näher, bis sie sich schließlich gegenseitig vernichten und Photonen zurücklassen. Das Ende ist eine formlose Wüste aus Strahlung und Teilchen, die sich in der Ewigkeit verliert. Wenn nichts passiert, macht das Konzept der Zeit keinen Sinn mehr, und die Zeit hört auf zu existieren.

Kritische Dichte <1: Nach 1014 Jahren kommt die Wasserstofffusion zu höheren Elementen in den Sternen zum Stillstand. Sie erlöschen langsam, einer nach dem anderen. Das Universum besteht nur noch aus Planeten, Zwergsternen, Neutronensternen und Schwarzen Löchern. In 1017 Jahren wird sich auch die Lichtstrahlung des Restgases verlangsamen und auf die verbleibenden Sterne treffen. In 1026 Jahren senden Galaxien Gravitationsstrahlung aus. Die verbleibenden Sterne bewegen sich langsam spiralförmig in das Zentrum der Galaxie. Wenn die derzeitigen Theorien über die Entstehung des Universums zutreffen, müsste sich das Proton mit einer Halbwertszeit von 1032-1036 Jahren teilen. Einige Theorien, die eine Zerfallszeit von weniger als 1034 Jahren vorhersagen, können bereits ausgeschlossen werden, da bisher kein Protonenzerfall beobachtet werden konnte. Daher ist es unmöglich zu sagen, dass die Theorien, die eine längere Zerfallszeit vorhersagen, korrekt sind. Sollte dies der Fall sein, wäre die Hälfte der verbleibenden Materie im Universum nach 1036 Jahren in Positronen zerfallen. Spätestens nach 1039 Jahren wären demnach alle Protonen im Weltall zerfallen. Das wäre auch das Ende aller Atome, Moleküle, Planeten und anderer Himmelskörper, da die Atomkerne teilweise aus Protonen bestehen. Das Universum würde nur noch aus Licht, Elektronen, Positronen und schwarzen Löchern bestehen. Nach 1064-1067 Jahren beginnen die schwarzen Löcher langsam zu verdampfen. Die letzten und ehemals größten werden nach 10100 Jahren in einer Explosion enden. Ob Schwarze Löcher tatsächlich verdampfen, ist bisher nur eine Hypothese. Wenn das Proton nicht zerfällt, werden die Zwergsterne nach 101000 Jahren zu Neutronensternen. Nach 101026-101074 Jahren werden sich die Neutronensterne zu Schwarzen Löchern entwickelt haben, die dann verdampfen werden. Nach dieser Zeit wird das Universum nur noch aus Elementarteilchen bestehen.

Abb. 1. Krümmung des Universums in Abhängigkeit vom Dichteparameter [48]

Unabhängig von den möglichen Zukünften des Universums hat es nach menschlichen Maßstäben lange gedauert, bis der gegenwärtige Zustand des Universums erreicht wurde, und die Entwicklung wird noch lange weitergehen, bevor es zu seinem thermodynamischen Tod oder Zusammenbruch kommt. Daher ist eine Simulation des Universums oder von Teilen davon, die in Echtzeit abläuft, nicht sinnvoll, wenn wir erwarten zu erfahren, ob sich die Simulation wie das echte Universum verhält. Man sollte annehmen, dass man, wie bei den heutigen Computersimulationen, die Zeit beschleunigen kann, um schnellere Erkenntnisse zu gewinnen. Es stellt sich jedoch heraus, dass der Versuch, das Universum genau zu simulieren, einige Einschränkungen für die Simulationszeit mit sich bringt, wie in den folgenden Kapiteln erläutert wird.

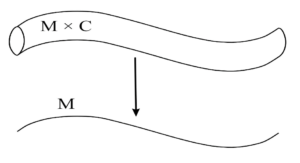

VI. SIMULATION VON INNEN UND VON AUSSEN

Bevor wir die Simulation unseres Universums erörtern, müssen wir zwischen einer Simulation unseres aktuellen Universums und einem beliebigen Universum unterscheiden. Die Frage, ob es möglich wäre, bei einer exakten Simulation des von uns bewohnten Universums die Zukunft vorherzusagen, ist nicht nur interessant zu stellen, sondern auch wichtig zu beantworten, da sie uns an die ultimative Grenze der Berechenbarkeit führt, sowohl in Bezug auf die physikalischen Gesetze als auch auf die Komplexität. Wir unterscheiden zwischen der Simulation des Universums und der Simulation eines Universums. Ersteres bezieht sich auf die exakte Simulation des Universums, in dem wir leben (unser Universum), letzteres entweder auf einen Teil des Universums oder ein unspezifisches Universum, das auf denselben physikalischen Gesetzen wie das Universum beruhen kann oder auch nicht. Es werden eine Reihe von Annahmen über unser Verständnis der Entwicklung des Universums und alles darin getroffen, einschließlich astronomischer Objekte wie Planeten, Sterne, Nebel, Galaxien und Sternhaufen sowie dunkle Energie, dunkle Materie, das interstellare Medium, die Ausdehnung der Raumzeit und die Geometrie des Universums sowie die universellen Konstanten – die Lichtgeschwindigkeit im Vakuum, die Planck-Konstante, die Boltzmann-Konstante und die Gravitationskonstante, um nur einige zu nennen. Da unser heutiges Wissen über das Universum bei weitem nicht vollständig ist, werden für die nachfolgend vorgestellten Argumente einige Annahmen getroffen:

- Wir (oder ein externer Programmierer) verstehen die physikalischen Gesetze, die die Evolution und die Zusammensetzung des Universums regeln, vollständig bis zur Ebene X. Dies beinhaltet ein vollständiges Verständnis der Kosmologie des Universums, einschließlich aller astronomischen Objekte, der Anfänge des Urknalls und der Inflation bis hin zur gesamten Materie – einschließlich der dunklen Materie -, der dunklen Energie und aller Gesetze auf der jeweiligen Skala, wie Relativität und Quantenphysik. Ein vollständiges Verständnis aller physikalischen Gesetze ermöglicht es uns (oder einem externen Programmierer), die Entwicklung des Universums in geeigneter Weise zu modellieren und Teile davon zu simulieren. Dies ermöglicht auch die Entstehung von Leben in der Simulation. Diese Annahme ist heute nicht mehr zutreffend.

- Die Gesetze der Quantenphysik sind die grundlegendsten physikalischen Gesetze bis hinunter zur Ebene X. Die Beschränkungen, die die Quantenphysik der Gewissheit auferlegt, bestimmen, wie genau wir in unserem Universum messen können. Die Planck-Einheiten sind die zugänglichen Grenzen von Zeit, Raum, Masse und Temperatur, über die hinaus kein physikalisches Gesetz Bedeutung hat. Es gibt wissenschaftlich fundierte Experimente und starke Anzeichen dafür, dass dies zutrifft, aber es bleiben viele Fragen offen, z. B. wie sich die Quantenphysik mit der allgemeinen Relativitätstheorie vereinbaren lässt. Daher ist diese Annahme heute nur teilweise zutreffend.

- Ein externer Programmierer kann beschließen, ein Universum zu simulieren, in dem dieselben physikalischen Gesetze gelten wie in seinem Universum, oder die Simulation auf andere physikalische Gesetze stützen. Wenn wir als externer Programmierer die Absicht haben, Hinweise darauf zu finden, ob wir an einer Simulationskette teilnehmen, scheint es vernünftig, die Simulation auf dieselben physikalischen Gesetze zu stützen, die in dem Universum herrschen. Ein externer Programmierer des Universums kann ebenfalls nicht wissen, ob er an einer Simulationskette teilnimmt, und wir gehen davon aus, dass ein externer Programmierer ebenfalls Anhaltspunkte dafür finden möchte, ob es wahr ist oder nicht, und eine Simulation eines Universums auf die gleichen physikalischen Gesetze stützen würde, die er in seinem Universum beobachtet. Da wir über die Simulation eines Universums nachdenken, wird die Frage, ob das (unser) Universum auf denselben physikalischen Gesetzen beruht wie das Universum eines potenziellen externen Programmierers, irrelevant: Wenn wir als externe Programmierer agieren und unserer Simulation dieselben physikalischen Gesetze zugrunde legen wie unserem Universum, und wenn eine Simulationskette entsteht, in der nachfolgende externe Programmierer ihren Simulationen ebenfalls dieselben physikalischen Gesetze zugrunde legen, dann sind die Handlungen dieser externen Programmierer Kandidaten für Beobachtungen, nach denen man im Universum suchen kann, unabhängig davon, ob letzteres auf denselben physikalischen Gesetzen wie das Universum eines potenziellen externen Programmierers beruht.

Die Ebene X bezieht sich auf die tiefste physikalische Strukturebene der Materie und die physikalischen Gesetze, die auf dieser Ebene gelten. Eine der Hypothesen der Stringtheorie besagt, dass Quarks – die Bestandteile von Hadronen, einschließlich Protonen und Neutronen – und Elektronen aus noch kleineren vibrierenden Energieschleifen bestehen, die Strings genannt werden, und dass dies die grundlegendsten Elemente sind, aus denen alle Materie besteht. Es wird von entscheidender Bedeutung sein zu verstehen, ob X auch die Granularitätsebene ist, auf der eine “ausreichend gute” Simulation beruhen muss, da beispielsweise die Funktionsweise eines makroskopischen Motors nicht allzu sehr vom Verhalten einzelner Quarks beeinflusst zu werden scheint.

Außerdem muss zwischen Simulation und Emulation unterschieden werden. Äußerlich verhält sich eine Emulation des Universums genauso wie das reale Universum, aber die internen Zustände der Emulation müssen nicht mit denen des realen Universums identisch sein. So muss eine Emulation beispielsweise nicht dieselben physikalischen Gesetze und Verhaltensweisen auf unbeobachteten Skalen, d. h. bis hinunter zur Ebene X, berücksichtigen, solange sie sich auf den gewünschten beobachteten Skalen genau wie das Universum verhält. Andererseits repräsentiert eine Simulation des Universums in ihrem internen Zustand alle physikalischen Gesetze und Zustände der simulierten Bestandteile genau so, wie sie außerhalb der Simulation sind. Sowohl die Simulation als auch die Nachbildung des Universums können überzeugende Ergebnisse liefern. Eine Simulation bildet jedoch die Grundlage für die weitere Diskussion, da nicht nur das Verhalten nachgeahmt, sondern auch Teile des Universums reproduziert werden sollen, so dass die Simulation sowohl intern als auch extern vom realen Universum physisch nicht zu unterscheiden ist.

A. Simulation des Universums

Die Durchführbarkeit einer Simulation des Universums, genauer gesagt einer exakten Simulation des von uns bewohnten Universums in voller Größe und Komplexität, die es uns ermöglichen würde, künftige Ereignisse vorherzusagen und beliebige Zustände in der Zeit rückwärts exakt zu simulieren, kann selbst unter den oben genannten Annahmen logischerweise ausgeschlossen werden. Mehrere Beschränkungen der Berechenbarkeit verhindern die Erstellung einer solchen Simulation. Wenn das Universum exakt simuliert werden soll, muss die Simulation auch den für die Simulation verwendeten Computer umfassen, den wir als “Simulation von innen” bezeichnen. Bei der “Simulation von außen” hingegen ist der interne Zustand des Computers, der für die Simulation des Universums verwendet wird, vom Zustand des Universums entkoppelt.

- Jede Simulation erfolgt in diskreten Zeitschritten und wird einen Zeitschritt nach dem anderen vorhersagen, bis die gewünschte Vorhersagezeit erreicht ist. Nehmen wir an, die Simulation beginnt zum Zeitpunkt t0 mit der Erwartung, t1 zu simulieren, um den Zustand des Universums zum Zeitpunkt t1 vorherzusagen, und die Rechenzeit tc, um dies durchzuführen, ist kleiner als t1 (siehe Gleichung 11).

t0=t1-tc (11)

Wenn der Computer den Zustand des Universums zum Zeitpunkt t1 in tc vorausgesagt hat, hat er auch seinen internen Zustand zum Zeitpunkt t1 vorausgesagt. Wird der Computer gebeten, den Zustand des Universums zum Zeitpunkt t2 vorherzusagen, so wird er seine Vorhersagen auf den Zustand des Universums, einschließlich seiner internen Konfiguration zum Zeitpunkt t1, stützen. Da jedoch tc<t1 ist, würde der Computer beginnen, seine interne Konfiguration zu ändern, um den Zustand des Universums bei t2 vorherzusagen, bevor t1 erreicht ist, und seine ursprünglichen Vorhersagen über seinen internen Zustand bei t1 sind nicht korrekt, wenn t1 erreicht ist. Egal wie klein die Zeitschritte sind, solange tc kleiner als t1 ist, tritt dieses Problem auf, was zu der Schlussfolgerung führt, dass ein Computer innerhalb des Universums nicht dazu verwendet werden kann, das Universum zu simulieren; er kann nur ein Universum simulieren, entsprechend unserer zuvor gemachten Definitionen. Der Kern dieses Arguments ist, dass eine Simulation des Universums nicht schneller laufen kann als die Echtzeitentwicklung des Universums und dass die Zukunft des Universums nicht vorhergesagt werden kann, wenn die Vorhersage exakt sein soll. Denn der Computer wird immer seinen eigenen falschen internen Zustand vorhersagen, solange tc<t1 ist. Wenn tc=t1 und keine anderen Einschränkungen gegeben sind, würde die Simulation korrekte Ergebnisse liefern, aber in Echtzeit ablaufen. Im Folgenden nennen wir dies die Einschränkung der rechnerischen Vorhersagbarkeit.